🔧 阿川の電商水電行

1: 魔法字詞的死與科學驗證的黎明

巷間耳語著「提示工程的終結」。

實際上,隨著AI性能的提升,即使不精細研究作文技巧,也能穩定地獲得高品質的輸出。

但是這並不意味著技術的「死亡」。

提示工程終於結束了依賴個人感受的「寫作技術」或「咒語」的『詐騙者與五花八門的無名小卒聚集的可疑時代』,

正逐步進化為更具系統性與可重複性的「情境工程(資訊環境設計)」,

更進一步設計AI的思考過程的「認知提示」(思考函數設計),進入『正當工程的時代』。

Google官方資料揭示的「時代的終結」

其象徵是2025年1月Google公開的技術資料「Prompt Engineering Whitepaper」。

這份資料集合了「角色設定」和「步驟思考」等技術。

實際上,這是一個這些技巧已經變成一般常識的官方宣告。

然而,本質仍然有所不同。

資料後半介紹的「ReAct」或「思維樹(ToT)」(思考連鎖的進化型)的技巧,超越了簡單的提示框架,

從提示工程的黎明期就存在的理論體系,但這些技術以非常誤解的方式廣泛流傳。

「分階段指示」、「分解任務」、「結構化」等似乎抽象而簡單的翻譯提示,許多人可能都曾模糊實踐過,但幾乎實際感受到效果的人不多。

但是,當你解讀原始理論時,會發現其微妙之處有著顯著的差異。

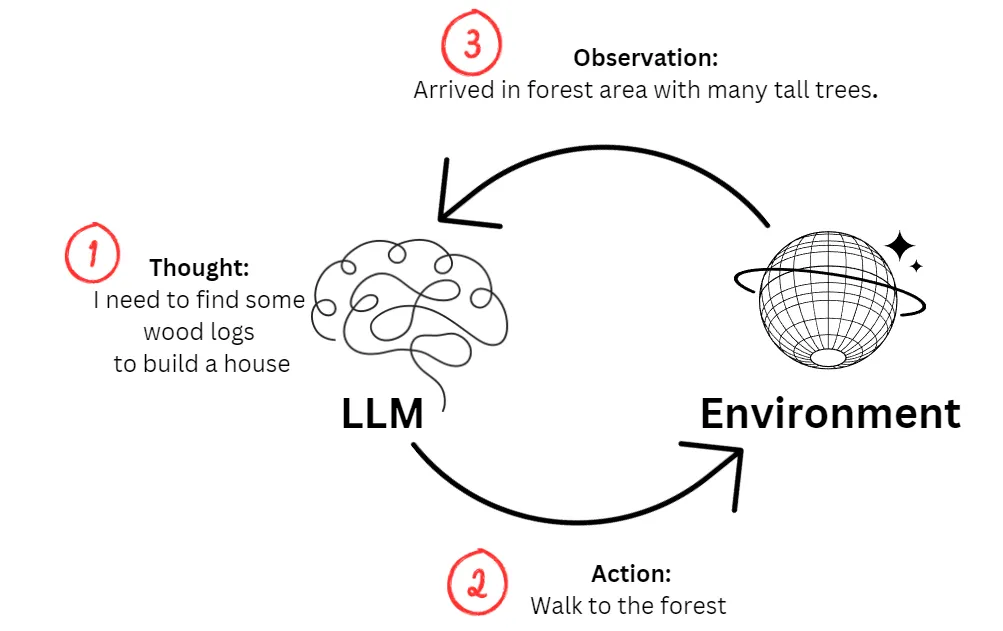

舉個例子,讓我們看一下ReAct (Reason + Act)這一方法。

這一理論的本質並非「隨意行動」,而是:

- 先整理思考(Reasoning),

- 依計畫執行(Acting),

- 觀察所得結果,並作為下一次思考的材料(Observation)

透過這樣的思考與行動的明確循環,將人類的真理應用於AI,以達到更高的效率。

然而,這個「思考和行動的回路」的動態本質被忽略了,只有像是「分解任務」這樣模糊且效果有限的做法被截取並流傳開來。

在學術的基礎上,

- 「何時進行(When)」

- 「在哪個領域(Where)」

- 「用什麼策略(How)」

- 「為何進行(Why)」

的体系了解缺失,使得只學會了對症療法的提示,卻錯誤地認為自己已經理解了,這正扭曲了這項技術的本質價值。

透過AI這面鏡子,我們日常如何粗略地使用『語言』的現實,正逐漸被科學化揭示,這種觀點呼應了「提示工程已經死亡」的說法,當前正被廣泛討論。

這既是一種對於我們最親近工具的漠視,也是我們「反思」的過程本身。

為何必須寫上「擁有10年經驗的Python工程師」?

這一現實揭示了最著名的「魔法字詞」角色設定的本質。

你是一位〇〇的專家。許多人都不假思索地寫「你是一位〇〇的專家」。

然而,越是熟練的人越會直覺地感受到僅此不足,無意識中添加了具體性=情境。

你是一位擁有10年經驗的Python工程師。

請根據你在FastAPI和Uvicorn上開發的經驗回答問題。這一直覺的巧思,實際上有其科學根據。

【有益的刃】:啟動思考引擎的角色

- 什麼角色?

如「裁判」、「程式設計師」等,具有客觀明確的思考流程的專業職位。 - 為何有效?

當指示AI以「專家」的身份行事時,這會促使它自發地有條理地思考(思考連鎖)並顯著提升解決複雜問題的準確率 (arXiv:2308.07702)。 - 結論:特別有效於需要邏輯分析或專業知識的情況。

添加如「經驗年數」或「使用技術」等可信的細節,可以進一步聚焦思考,提高準確性。

【無益的刃】:僅改變語調的角色

- 什麼角色?

如「老師」、「母親」等,更著重於一般性的人格或態度的角色。 - 為何無效?

幾乎無法對客觀任務的性能有所貢獻 (arXiv:2311.10054)。AI會變得更有禮貌,但不會變得更聰明。 - 結論:不應用於提高答案的質量。

不必要的細節反而會成為阻礙AI思考的干擾因素。

【有害的刃】:破壞思考的角色

- 什麼角色?

涉及種族、性別、宗教等與個人身份有關的角色。 - 為何危險?

可能放大網上的扭曲偏見(偏見),使推論性能降低超過70%,造成嚴重的負面影響 (arXiv:2311.04892)。 - 結論:絕對不應使用。

這是破壞AI邏輯性及再生產有害刻板印象的極其不負責任的行為。

這項技巧的關鍵在於其角色是否具備,

- 「客觀明確的思考流程」或

- 只是「主觀的印象」。

例如,以下的角色設定看似在指示專業性,但實際上卻是混淆了AI的選擇,典型的例子如下。

-

「專業的會議記錄員」

看似具體,但「會議記錄」所需的思考流程隨不同語境全然不同。內部會議需要提煉要點的編輯思考,而正式的國會答辯則需要逐字逐句的紀錄思考。AI無法判斷該以哪種模式運作,最終產生中規中矩的輸出。 -

「頂尖顧問」「一流商人」

「頂尖」或「一流」是主觀評價,無法給予AI具體的思考軸;結果只是信心十足地羅列毫無內容的商業術語而已。 -

「溝通的高手」

這也是模糊的。「溝通」的目的(說服、共鳴、傳遞信息等)模糊不清,因此AI無法判斷應發揮何種能力。

這些完全是將「角色」這一名稱的衣裝穿在AI身上,卻未能正確啟動其頭腦中的思考引擎。

歸根究底,我們對於角色扮演的期待並不僅僅是口調的模仿。而是希望將該角色所具備的邏輯思考框架安裝到AI身上,並讓其活用。

AI不會「揣測」你的意圖

到目前為止的討論顯然,人與人之間的對話依賴於大量的「隱性知識」,而與AI的對話則完全不存在這些背景。

與人類對話中,對方可能會「揣測」我們的意圖並給出最佳建議。

但是,AI是一個沒有「揣測」意圖的純資訊處理機器。

在與AI的對話中,總是需要人類主動「揣測」,並將所有必要的信息語言化並提供。

這就是提示工程必須迈向下一階段的必然性。

2: 隱性知識的形式知化:情境工程的時代

「情境工程」這一詞,是自2025年夏季開始,由前特斯拉AI負責人、OpenAI創始成員安德烈·卡爾帕西等全球頂尖專家提出的概念。

我支持「情境工程」這一詞,

因為情境工程才能為下一步提供「恰當情報」的微妙藝術與科學。

其本質在於,重新定義與AI的對話,從「指令(提示)的互動」轉向「資訊環境(情境)的設計」。

| 觀點 | 舊有提示工程 | 情境工程 |

|---|---|---|

| 主要對象 | 靜態的「字串(String)」 | 動態的「資訊環境(System)」 |

| 目的 | 手動探索最佳的「咒語」 | 自動優化以獲得預期輸出的「文脈生成」 |

| 方法 | 感覺、提示集 | 信息物流、系統設計 |

這一轉變的背景有兩個巨大技術變化。

- 情境窗口的爆炸性增長

- RAG(從外部資料庫的動態信息檢索)的普及

如今主戰場不再是「如何改進單一的指令」。

而是要建構「最佳文脈」,以作為系統的方式進行高度設計,徹底轉變為此。

「那個,拿過來」AI為何無法理解的理由

人類之間的對話驚人地依賴於情境。

若在餐桌上對家人說「那個,拿過來」,會立即傳達出眼前指向的是醬油瓶。這裡包含了:

- 共享的物理空間(「餐桌」的場所)

- 過去的經驗(總是用醬油)

- 關係性(彼此是家人)

等大量的「隱性前提」。

然而與AI的對話完全缺乏這些前提。

對AI而言,我們的要求始終只是「脫離情境的文本數據」。

為使AI能夠執行任務,需設計並語言化所需的資訊環境。

這就是「情境工程」的核心。

情境的構成要素:為AI設計世界的「七種工具」

優秀的情境工程並不僅僅是寫長的指令。

它是設計AI思考的「初始設定」的行為。

透過意識地語言化和結構化以下「七種工具」,可以引導AI的思考。

| 要素 | 說明 | 具體例子 |

|---|---|---|

| 前提(Premise) | 思考的基礎,堅定的基本方針和共識。 | 「我們公司的品牌形象是『可信賴』和『創新』。」 |

| 情境(Situation) | 任務產生的直接背景或目前的具體情況。 | 「競爭對手A公司開始了降價促銷,市場份額正在被搶奪。」 |

| 目的(Purpose) | 透過這次對話最終想要達成的具體目標。 | 「想要集思廣益,策劃出三個對抗的活動方案。」 |

| 動機(Motive) | 為何希望達成該目標的根本理由或意圖。 | 「短期內提高銷售是目的,但真正的狙擊是提升客戶忠誠度。」 |

| 限制(Constraint) | 必須遵循的規則、條件、限制。 | 「預算在500萬以內,遵循法務部的合規指導。」 |

| 形式(Format) | 預期輸出的具體結構或風格。 | 「每個方案的目標、方法、預期效果都以要點形式歸納。」 |

| 參考(Reference) | 應使用的信息來源、數據、範本。 | 「分析附上的過去成功案例PDF,提取對此次企劃有幫助的要點。」 |

通過這些要素的組合,我們可以為AI構建出「像放在餐桌上的醬油瓶」這樣的虛擬情境,

從而極大提高任務成功的幾率。

這已經不再是黑客AI的「秘技」。

而是和AI這種「無意志之智」合作的極具邏輯性和可重複性的「合作設計技術」。

RAG(資訊) vs 提示(知識體系)

理解構成情境的兩大因素,RAG和提示之間的本質區別也至關重要。

- RAG提供「資訊」。

- 提示提供「觀點的體系」。

提示的真正價值在於設置LLM的「觀點體系(思考框架)」。

讓我們通過具體的商業分析例子來思考這一區別。

假設要分析某公司A的經營狀況。

案例①:僅提供RAG的情況(僅給大量的魚)

獲取A公司的財報和新聞報導,然後指示AI如下。

請依據以下資料,總結A公司的狀況。

[RAG所獲得的大量文本數據...]這樣會僅得到「資訊列表」,無法用於決策。

案例②:提供RAG和優秀的提示(教會烹飪魚)

使用相同資訊(RAG),但在提示中指定「思考的型態」。

請依據以下資料,使用**SWOT分析框架**分析A公司的情況。

[RAG所獲得的大量文本數據...]這樣的指示使得AI從單純的摘要機器轉變為分析工具。

AI會通過「SWOT分析」的視角來篩選和分類資訊,生成如「A公司的優勢是技術力,但劣勢是營銷力」的結構化見解。

RAG提供大量的魚,而優秀的提示則是教會AI如何將魚製成「刺身」、「烤魚」和「燉魚」。

優秀的「思考型態」的缺乏會使得大量的信息無法發揮意義。

這一挑戰超越了情境工程的範疇,引導我們進入設計AI的「思考過程」的下一階段。

3:設計AI的「思考過程」的時代:認知提示

如果情境工程是設計AI所需之輸入(Input)的工程,那麼其前方則是

工程學地處理AI的推理過程(Process),全新的地平在待開展。

這是時代的開端:從「想要什麼(What)」,到「希望如何思考(How)」,即設計AI的思考過程的時代。

情境工程之後的地平

為了教會AI「更好的思考方式」,新的設計方法不斷湧現。

這裡介紹三種代表性的方法。

1. 認知提示(Cognitive Prompting)

- ― 將人類的思考流程安裝到AI中 ―

- 思考方式:將人類解決問題的思考流程(設置目標、分解問題、資訊過濾等)作為AI的指示(提示)的方法。通過模仿人類的問題解決過程,引導LLM的思考。(論文鏈接)

不良範例 ✗:

請總結這篇文章。這樣會使得AI的判斷完全隨機。

良好範例 ✓(認知提示):

目的:文章的總結

因此,請順序執行以下思考流程。

1. **確定主張:** 將這篇文章最核心的主張(結論)提煉成一行。

2. **分解根據:** 按重要性列出支持上述主張的三個主要根據。

3. **整合和總結:** 最後使用步驟1和步驟2的結果,將整體總結為300字以內。【效果】

透過強制AI遵循「主張→根據→整合」的編輯者思考流程,而不是隨意地進行摘要,能顯著提高輸出的質量與一致性。

2. 後設認知提示(Metacognitive Prompting)

- ― 使AI「自我反省」而變得聰明 ―

- 思考方式:讓AI自身評估「自己的思考過程是否合適?」並給予自我修正的機會,以促進更可靠的推論。(解說鏈接)

不良範例 ✗:

請想出一份新的能量飲料的行銷計畫。這樣可能會產生不切實際或考量不足的計畫。

良好範例 ✓(後設認知提示):

首先,請為新的能量飲料提出**草案**的行銷計畫。

接著,作為自己最嚴厲的評論者,從以下三個角度**自我評價**該草案。

- 前提是否正確?

- 是否真正能打動目標群體?

- 在預算內是否可行?

最後,根據該自我評價,提出改善過的**最終版**草案。【效果】

通過將「自我反省回路」嵌入提示中,可以引導AI補強先前答案的弱點,誘發出更健全及現實的輸出。

3. 系統框架(Systematic Frameworks)

- ― 將提示結構化為「設計圖」―

- 思考方式:按照「角色」、「目的」、「約束」、「例外處理」等組成要素,系統性地設計提示,消除指示的含糊性,並提高回應的穩定性和可重現性。5C框架(arXiv:2507.07045)等方法為人所知。

不良範例 ✗:

請撰寫我們新服務的部落格文章。目標是年輕人,請用親切的語氣。 這樣會使得解釋的方式隨著負責人不同而變化,從而無法穩定質量。

良好範例 ✓(系統框架):

請根據以下框架撰寫部落格文章。

- **角色(Role):** 面向年輕人的科技媒體內容撰寫者

- **目的(Objective):** 提高新服務X的知名度並引導至預註冊網站

- **目標(Target):** 年齡在18至24歲的學生,尤其是喜歡小工具者

- **約束(Constraint):** 避免專業術語。字數限制在800字以內。

- **例外處理(Exception):** 不要直接提及競爭對手的產品名稱。

- **內文格式(Format):** 以Markdown格式撰寫。在文章結尾務必設置預註冊的鏈接。【效果】

無論是誰執行提示,均能保持輸出質量的一致性。指示的漏失會減少,帶來團隊協作的AI應用及業務流程的自動化時將發揮巨大的效果。

隨著新力量而來的責任

這個「設計思考」的力量,帶來了巨大潛力的同時,也隱藏著未知的風險。

亦即,「良好的思考框架」和「不良的思維習慣(認知偏見)」之間的界限可能非常微妙。

研究(arXiv:2506.12338)顯示,將人類的認知偏見(如:「受到首次信息的影響」)包含在提示中,會顯著降低AI的性能。

我們所期待的「思考指導」,真的幫助了AI嗎?或是無意中注入我們的偏見,歪曲它的能力?

正面臨的難題。

幫助思考的「鏡頭」,與扭曲推理的「色眼鏡」。

這一界限尚未有任何人能夠明確劃分。

4: 成為「對話設計者」的基本原則

提示工程結束了「咒語」的時代,進入探索人類認知領域的未知領域。

這項技術的普遍性反而增加了其習熟的難度。

為了克服這混沌的時代,需回到所有設計的基礎三個原則。

原則①:最終責任始終屬於人類

AI不可成為責任主體。

任何由AI的輸出所產生的後果,都是使用該輸出的人的責任。

將人類無法理解和判斷的事情委託給AI本身就是問題的根源。

原則②:假設「幻覺」存在,只處理可驗證的事實

幻覺是AI的「特性」。

AI活用的本質便是在於人類精確構建客觀的「驗證基準」的過程。

不要懷疑AI,而是必須時時懷疑自己。

原則③:追求原理(Why)和情境的一致性,而非方法(How)

AI模型持續變化,因此昨天有效的方法(How)明天可能就失效。

為了不被變化所影響,理解原理(Why),並持有堅定的「自身指導方針」是重要的。

不斷出現的技巧讓人不易集中精力,但最終問到的仍是你自身的「設計思考的能力」。

優秀的提示者並不是能在變化的浪潮中駕馭自如的人,

而是那個能夠不受波動干擾,主動深埋「對話目的」這個錨的個體。

隨著AI融入社會,這一「下錨能力」將不再僅屬於專業職稱。

而是每個人為自身思考與行動負責所需的新時代的素養。

原文出處:https://qiita.com/makotosaekit/items/21990e3703ac721a04d0

1) --- 會變成分隔線(上一行必須是空白)

2) # 會變成一級標題

3) ## 會變成二級標題

4) ### 會變成三級標題

5) **粗體文字**會顯示粗體文字

6) ```當第一行與最後一行會顯示程式碼

7) 請搜尋 Markdown 語法,了解各種格式