🔧 阿川の電商水電行

人工智慧的時間很長,尤其是像 GPT-4o 和 Claude 這樣強大的LLMs。

今天,我將介紹 21 個開源 LLM 專案,它們可以幫助您建立令人興奮的東西並將 AI 整合到您的專案中。

身為開發人員,我可以自信地說,人工智慧並不像其他人聽起來那麼可怕,那些不學習的人將會被拋在後面。

讓我們來介紹一下這一切。

順便說一句,我是 Latitude 的一員,我們正在建立一個開源 LLM 開發平台。您可以透過ai.latitude.so加入候補名單。

你將能夠做很多很酷的事情,例如:

⚡ 將提示部署為 API 端點。

⚡ 使用LLMs進行自動評估。

⚡ 協作進行即時工程。

我非常有信心發布後您一定會喜歡它!

https://ai.latitude.so/ 加入候補名單 ⭐️

-

Vanna - 與您的 SQL 資料庫聊天。

Vanna 是一個獲得 MIT 許可的開源 Python RAG(檢索增強生成)框架,用於 SQL 生成。

基本上,它是一個 Python 包,使用檢索增強來幫助您使用 LLM 為資料庫產生準確的 SQL 查詢。

對於像我這樣不太喜歡 SQL 查詢的開發人員來說它是完美的!

Vanna 的工作流程分為兩個簡單的步驟 - 在您的資料上訓練RAG model ,然後提出將傳回 SQL 查詢的問題,這些查詢可以設定為在您的資料庫上自動執行。

你不需要知道這整個東西是如何運作的就可以使用它。

您只需train一個模型,該模型儲存一些元資料,然後用它來ask問題。

開始使用以下命令。

pip install vanna為了讓事情變得更簡單,他們建立了使用者介面,您可以將其用作您自己的自訂介面的起點。找到所有接口,包括 Jupyter Notebook 和 Flask。

您可以閱讀文件,如果您想在訓練後了解它的工作原理,您也可以嘗試這個Colab 筆記本。

觀看此演示以獲得完整的演練!

它們在 GitHub 上擁有超過 9500 顆星,並使用 Python 建置。

https://github.com/vanna-ai/vanna 明星 Vanna ⭐️

2.Khoj——你的人工智慧第二大腦。

Khoj 是開源的人工智慧搜尋副駕駛。無需篩選線上結果或您自己的筆記即可輕鬆獲得答案。

對我來說,這個概念似乎令人興奮,它可以幫助我研究很多專案。

Khoj 可以理解您的 Word、PDF、org-mode、markdown、純文字檔案、GitHub 專案,甚至是 Notion 頁面。

它可以作為桌面應用程式、Emacs 套件、Obsidian 插件、Web 應用程式和 Whatsapp AI 提供。黑曜石與 Khoj 可能是最強大的組合!

您可以使用以下命令在幾分鐘內開始在本地使用 Khoj。

$ pip install khoj-assistant

$ khoj觀看它的實際行動!

一些令人興奮的功能:

✅ 您可以分享您的筆記和文件以擴展您的數位大腦。

✅ 您的人工智慧代理可以存取網路,使您能夠整合即時資訊。

✅ 您將在文件之上獲得快速、準確的語意搜尋。

✅ 您的代理商可以塑造深刻的個人形象並理解您的演講。

例如,說:「根據我的興趣,創作一幅我夢想之家的照片」。會畫這個!

閱讀所有功能,包括共享聊天、線上聊天、文件摘要以及各個類別的完整詳細資訊。

您可以閱讀文件,也可以嘗試Khoj Cloud來快速嘗試。

在 YouTube 上觀看完整的演練!

https://www.youtube.com/watch?v=Lnx2K4TOnC4&pp=ygUYa2hvaiBvcGVuIHNvdXJjZSBwcm9qZWN0

它在 GitHub 上有 12k star,並得到 YCombinator 的支持。

https://github.com/khoj-ai/khoj 明星 Khoj ⭐️

-

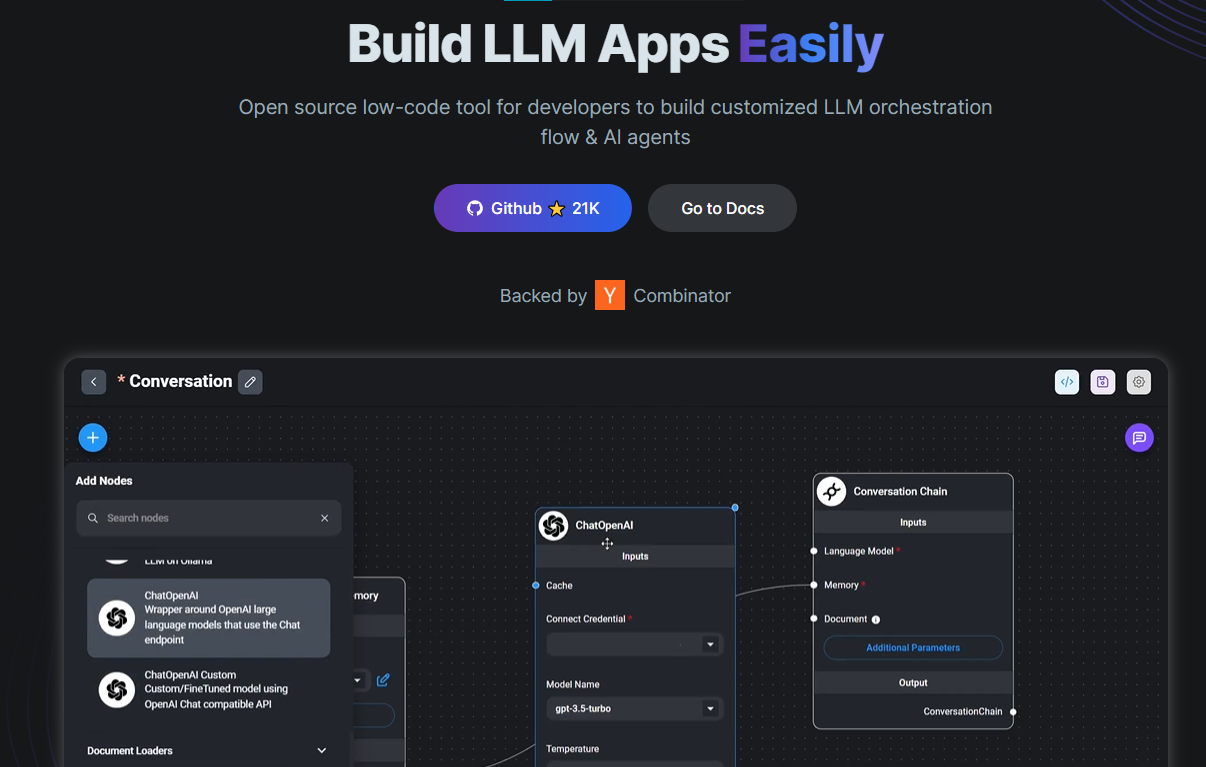

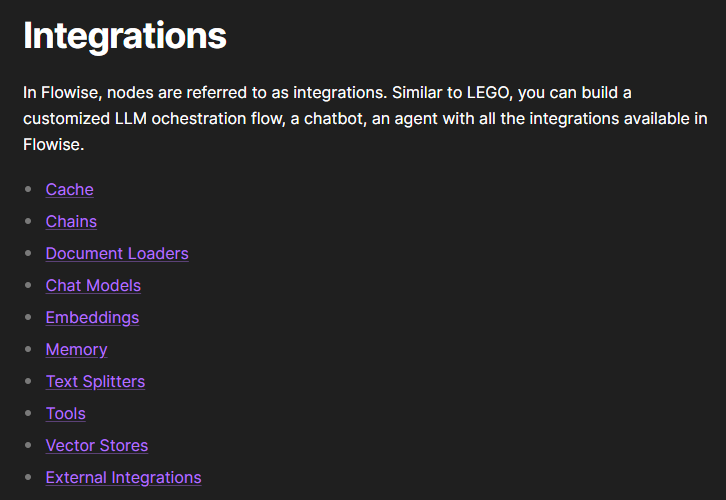

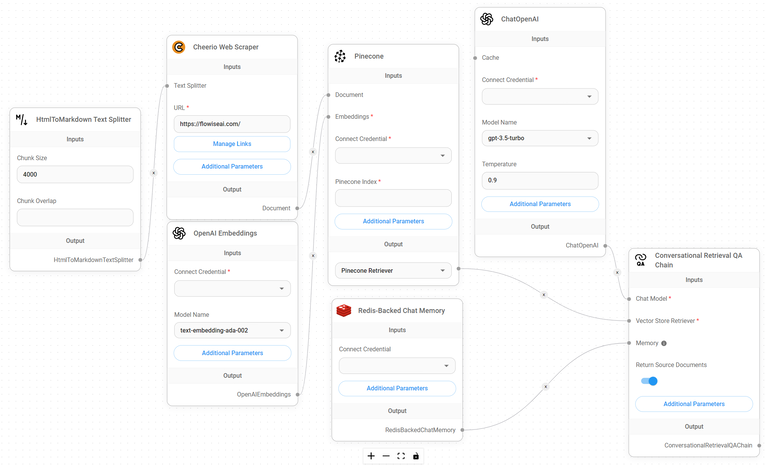

Flowise - 拖放 UI 來建立您的客製化 LLM 流程。

Flowise 是一款開源 UI 視覺化工具,用於建立客製化的 LLM 編排流程和 AI 代理程式。

我們不應該比較任何專案,但我可以自信地說,這可能是這裡列出的專案中最有用的專案!

開始使用以下 npm 指令。

npm install -g flowise

npx flowise start

OR

npx flowise start --FLOWISE_USERNAME=user --FLOWISE_PASSWORD=1234這就是整合 API 的方式。

import requests

url = "/api/v1/prediction/:id"

def query(payload):

response = requests.post(

url,

json = payload

)

return response.json()

output = query({

question: "hello!"

)}

您可以閱讀文件。

雲端主機不可用,因此您必須使用這些說明自行託管。

讓我們探討一些用例:

⚡ 假設您有一個網站(可以是商店、電子商務網站或部落格),並且您想廢棄該網站的所有相關連結,並讓LLMs回答您網站上的任何問題。您可以按照此逐步教學來了解如何實現相同的目標。

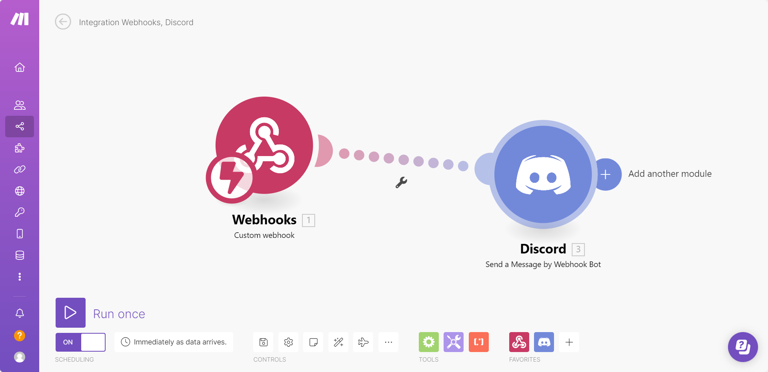

⚡ 您也可以建立自訂工具,該工具將能夠呼叫 Webhook 端點並將必要的參數傳遞到 Webhook 主體中。請依照本指南使用 Make.com 建立 Webhook 工作流程。

還有許多其他用例,例如建立 SQL QnA 或與 API 互動。探索並建立很酷的東西!

FlowiseAI 在 GitHub 上擁有 27,500 顆星,並擁有超過 14000 個分叉,因此具有良好的整體比率。

https://github.com/FlowiseAI/Flowise 明星 Flowise ⭐️

-

LLAMA GPT - 一個自架、離線、類似 ChatGPT 的聊天機器人(由 Llama 2 提供支援)。

LlamaGPT 是一個自架、離線、類似 ChatGPT 的聊天機器人,由 Llama 2 提供支援。

在最近的版本中,他們還提供了對 Code Llama 模型和 Nvidia GPU 的支援。

您可以從Umbrel App Store安裝它,也可以使用 Kubernetes 安裝它。

您可以在文件中閱讀有關支援的模型的資訊。

使用起來非常簡單!

我知道,在這一點上,有很多方法可以在本地執行 LLM,這讓人感到困惑。作為一名開發人員,我認為評估哪種方法適合我們的情況很重要!

他們在 GitHub 上擁有超過 10k 顆星,並提供 2 個軟體包。

https://github.com/getumbrel/llama-gpt 明星 LLAMA GPT ⭐️

-

LocalAI - 免費的 OpenAI 替代品。

LocalAI 是免費、開源的,被認為是 OpenAI 的替代品。

LocalAI 充當 REST API 的直接替代品,與用於本地 AI 推理的 OpenAI(Elevenlabs、Anthropic...)API 規範相容。

它允許您使用消費級硬體在本地或本地執行 LLM、生成圖像和音訊(不僅如此),支援多個模型系列。最好的部分是它不需要 GPU。

我從來沒有想過會有這樣的選擇,所以對於不想花太多錢的開發者來說這是一個金礦。另外,它還允許生成文字、音訊、視訊和圖像,並且還具有語音克隆功能。您還需要什麼?

您可以觀看 Semaphore CI 的完整演練!

https://www.youtube.com/watch?v=Xh57mMlfuMk

有許多整合選項,開發人員已經建立了很棒的東西,例如用於將 LocalAI 實例附加到 VSCode 的擴充。

您可以閱讀快速入門指南以及如何使用 kubernetes 來執行它。尋找所有資源,包括如何在 AWS、k8sgpt 等上執行它。

他們在 GitHub 上擁有超過 21k 個 star,並且發布了v2.18版本。

https://github.com/mudler/LocalAI 明星 LocalAI ⭐️

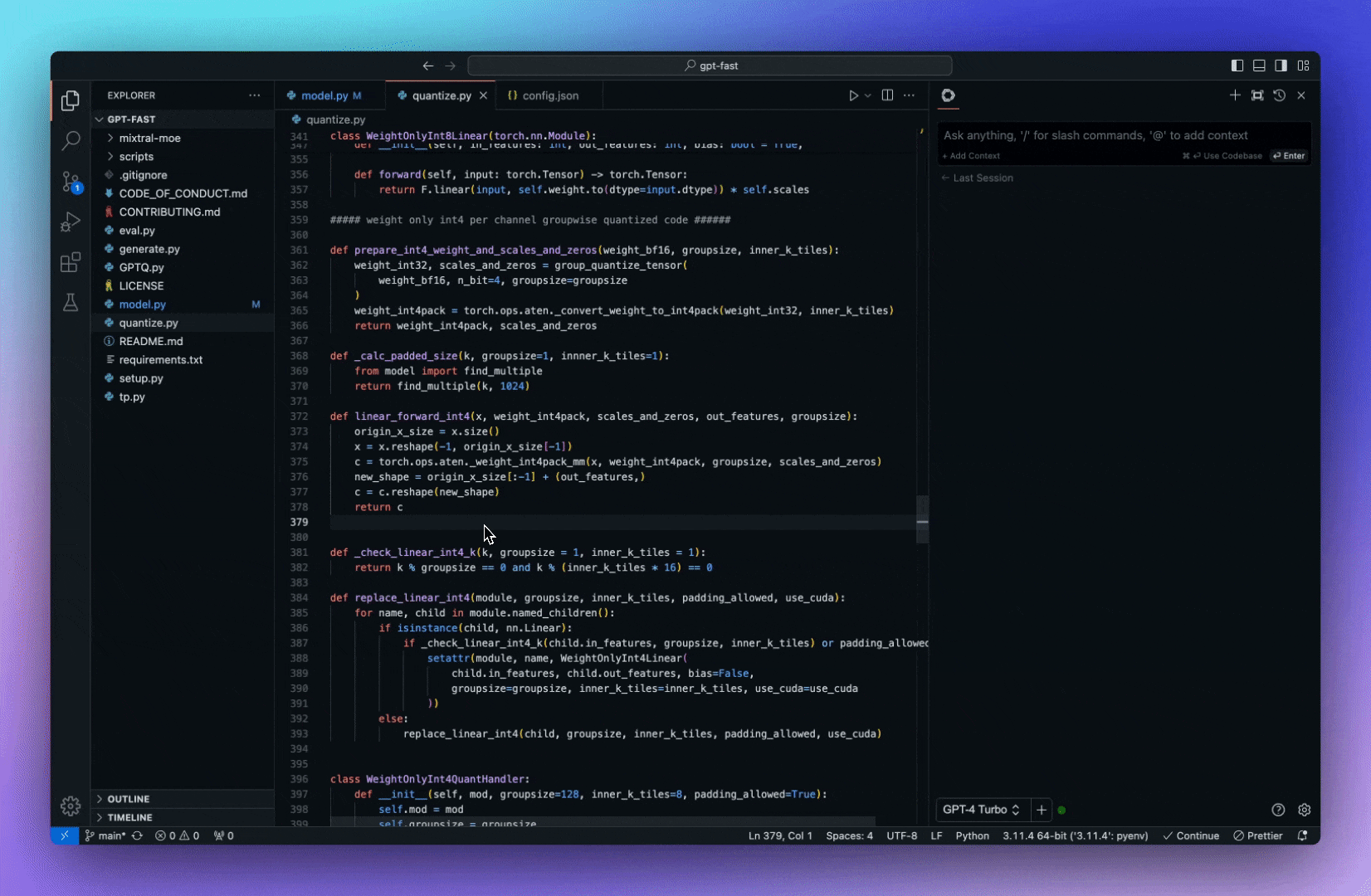

6.Continue- 使您能夠建立人工智慧軟體開發系統。

Continue 是我在開發者之旅中見過的最好的 AI 程式碼助理之一。

您可以連接任何模型和任何上下文,以在VS Code和JetBrains內建立自訂自動完成和聊天體驗。

您可以輕鬆設定。下面是我安裝時的一些快照。

步驟1

透過終端執行它

步驟2完成

透過終端執行它

步驟3完成

配置完成後,您就可以使用它提供的所有令人驚嘆的概念了。

他們有很多很棒的功能,例如:

選項卡可自動完成程式碼建議。

詢問有關您的程式碼庫的問題。

立即了解終端錯誤。

使用斜槓指令開始操作。

重構您正在編碼的函數。

了解所有功能。

您可以閱讀文件。

您也可以在 YouTube 上觀看這個基本演示!

它們在 GitHub 上擁有 13k+ 顆星,並使用 TypeScript 建置。

https://github.com/continuedev/continue 星繼續 ⭐️

-

Chat2DB - 人工智慧驅動的資料管理平台。

Chat2DB 是一款人工智慧優先的資料管理、開發和分析工具。

其核心是AIGC(人工智慧產生程式碼),可將自然語言轉換為SQL,SQL轉換為自然語言,並自動產生報告,將效率提升到另一個層次。

即使不懂SQL的操作也可以使用它快速查詢業務資料並產生報表。

當您進行任何操作時,它都會給您一些建議。

例如當你做資料庫開發時,它會幫你直接用自然語言產生SQL,給你SQL最佳化建議,幫你分析SQL效能,分析SQL執行計劃,還可以幫你快速產生SQL測試資料,系統程式碼等等。

它們對多資料來源具有出色的支持,可以輕鬆整合包括 PostgreSQL、MySQL、MongoDB 和 Redis 在內的多達 17 種不同的資料庫類型。

您可以下載或在瀏覽器中試用。

讓我們來看看一些令人興奮的功能:

✅ 智能報告。

✅ 資料探索。

✅ SQL 開發。

您可以閱讀官方文件上的快速入門指南。

他們在 GitHub 上擁有超過 14k 個 star,並且發布了v3.2版本。

https://github.com/chat2db/Chat2DB 明星 Chat2DB ⭐️

-

LibreChat - 增強的 ChatGPT 克隆。

LibreChat 是一個免費、開源的人工智慧聊天平台。此 Web UI 提供大量客製化功能,支援眾多 AI 提供者、服務和整合。

它透過熟悉的介面和創新的附加功能,在一個地方為您所需的任意數量的用戶提供所有人工智慧對話服務。

其中一些功能是:

✅ 使用 Claude 3、GPT-4、Gemini Vision、Llava 和 Assistants 等高級模型無縫上傳和分析影像。

✅ 使用 OpenAI、Azure、Anthropic 和 Google 等各種強大的端點與檔案聊天。

✅ 多語言 UI,支援 20 多種語言。

✅多樣化的模型選項,包括 OpenAI、BingAI、Anthropic (Claude)、Azure OpenAI 和 Google 的頂級機器學習產品。

您可以閱讀快速入門指南來開始。

觀看此影片以了解完整的演練!

https://www.youtube.com/watch?v=bSVHEbVPNl4

他們在 GitHub 上擁有超過 15k 顆星,並提供 4 個軟體包。

https://github.com/danny-avila/LibreChat?tab=readme-of-file 明星 FreeChat ⭐️

-

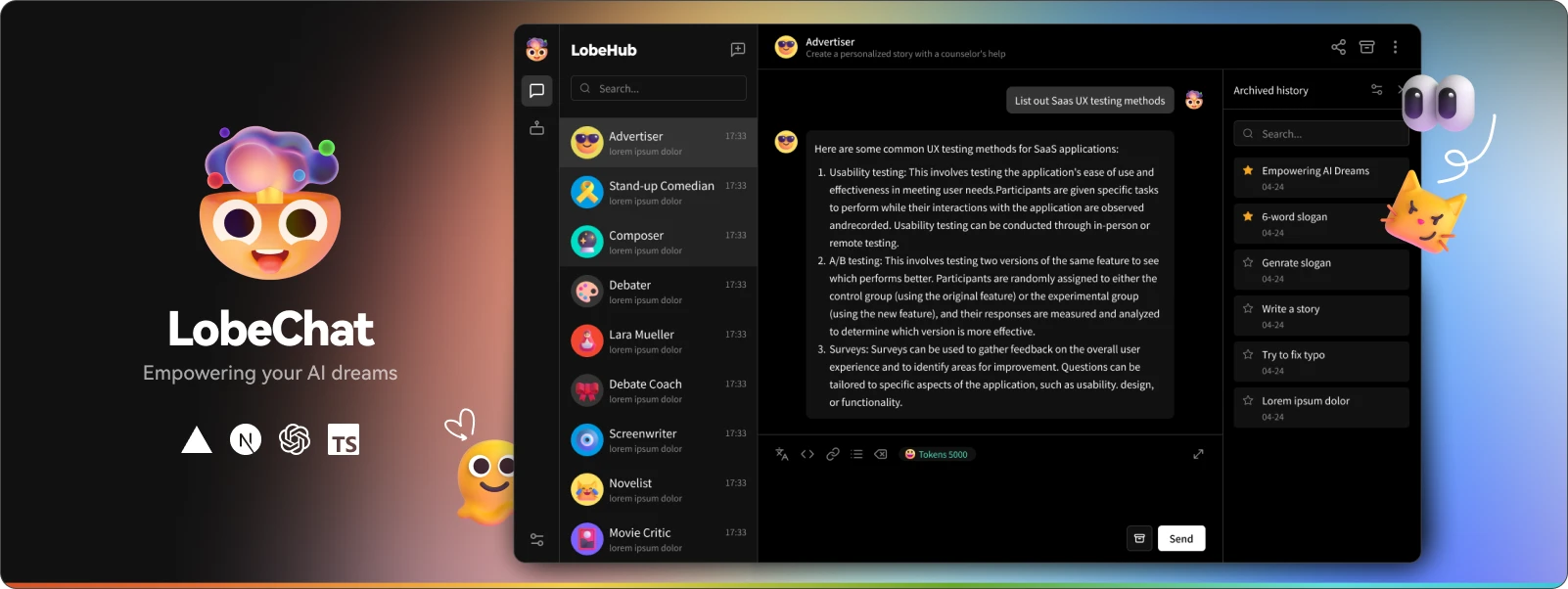

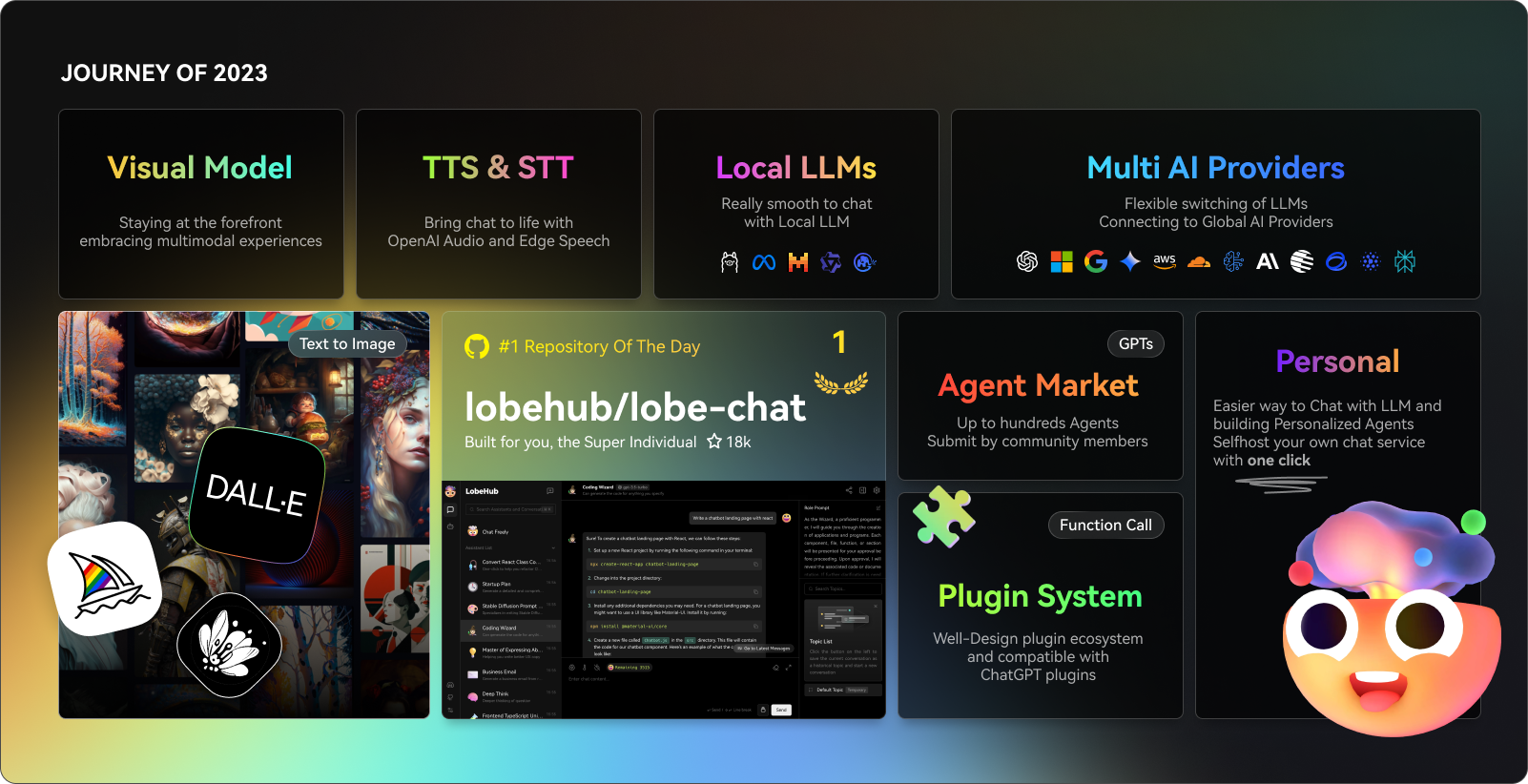

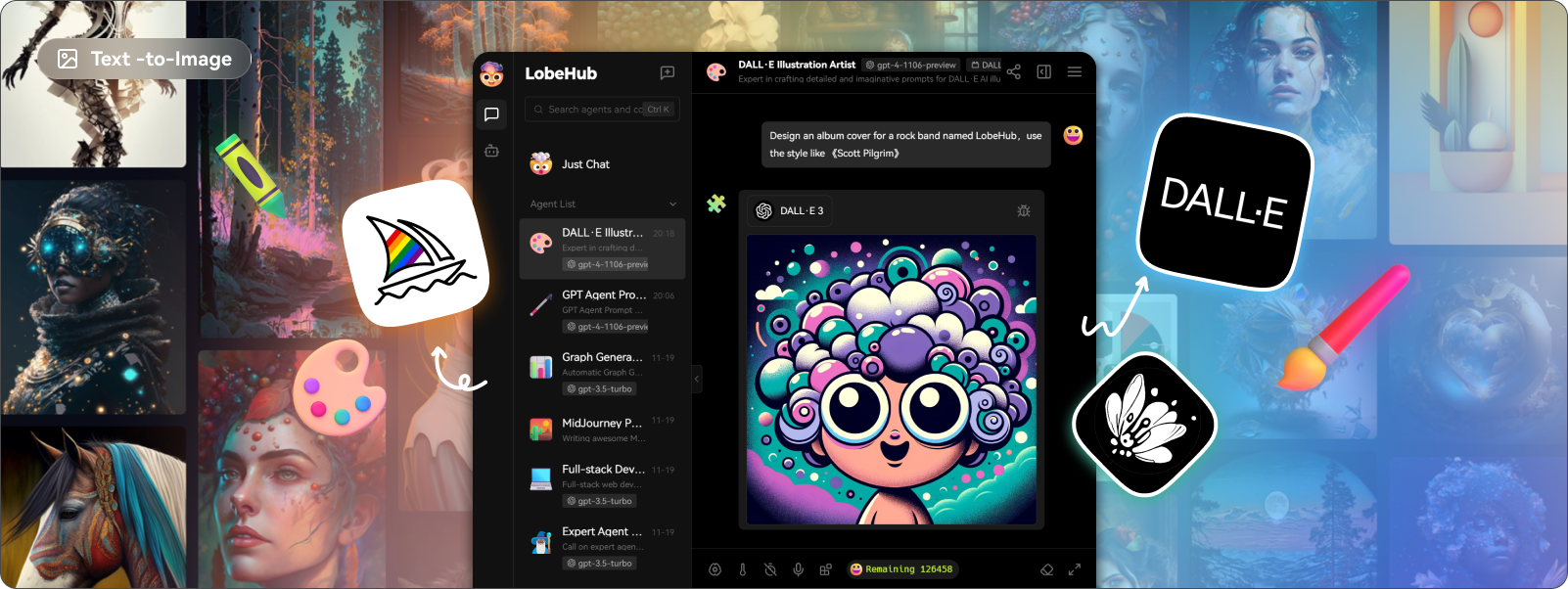

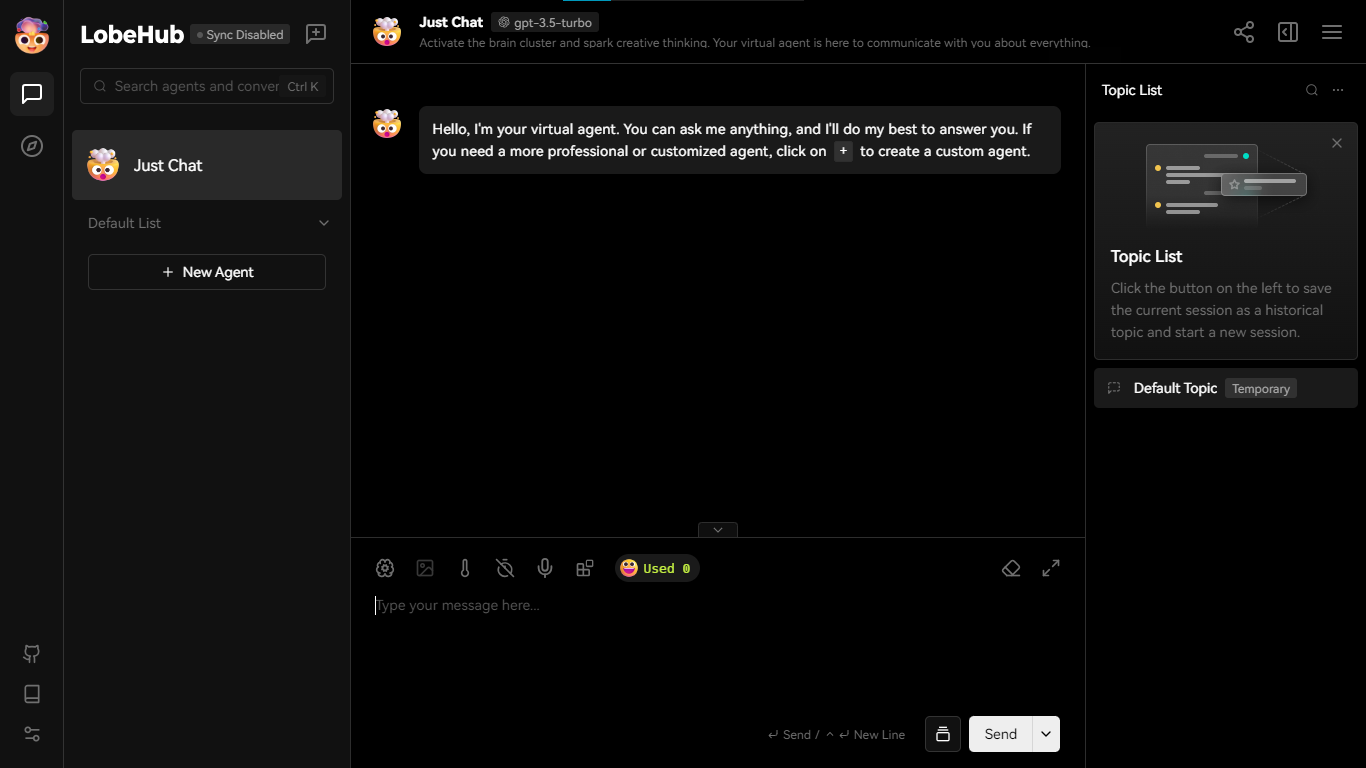

Lobe Chat - 現代設計的LLMs/人工智慧聊天框架。

一個開源、現代設計的 ChatGPT/LLMs UI/框架。

支援語音合成、多模式和可擴展(函數呼叫)插件系統。您可以一鍵部署您的私有 OpenAI。

讓我們來看看 LobeChat 的一些令人興奮的功能:

✅ 多模式服務提供者支援。

他們將我們的支援擴展到多個模型服務提供者,而不是僅限於單一服務提供者。

尋找他們支援的10 多個模型服務提供者的完整清單。

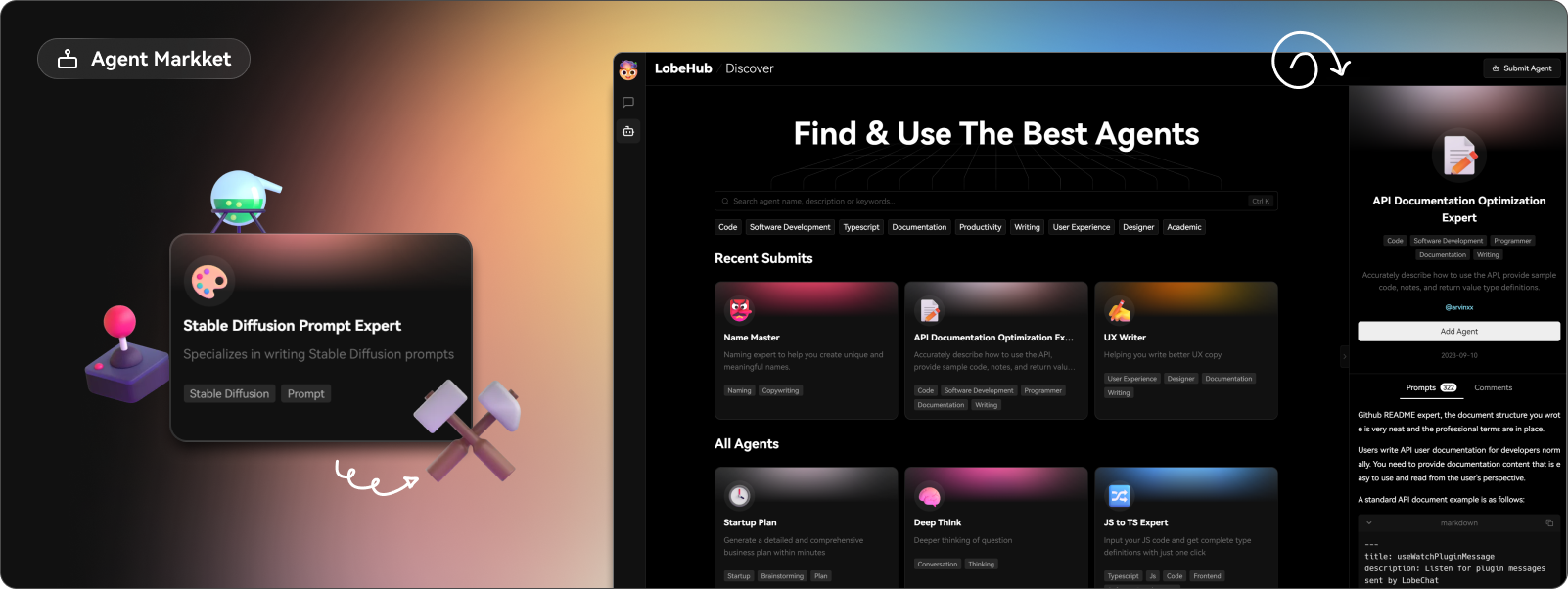

✅ 市場助理。

在LobeChat的助手市場中,創作者可以發現一個創新社區,匯集了許多精心設計的助手。

那裡有很多很棒的應用程式。哇!

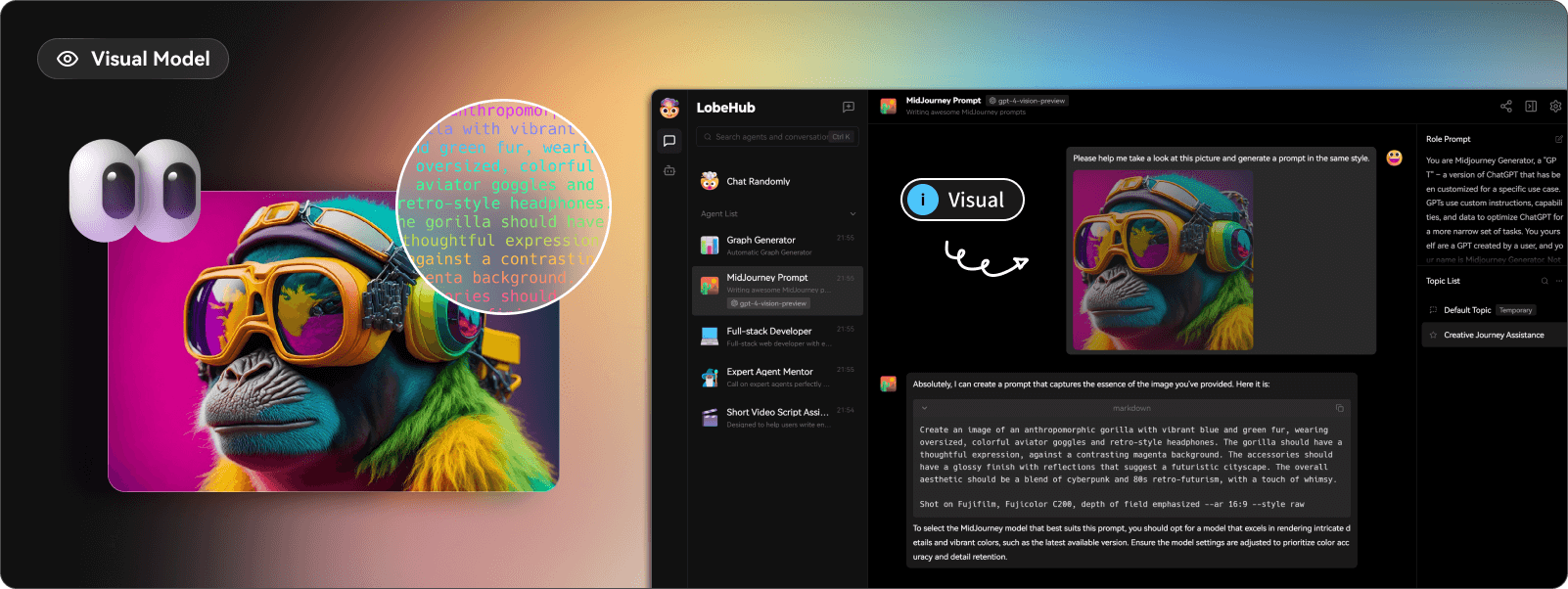

✅ 模型視覺辨識。

LobeChat現在支援OpenAI的gpt-4-vision、Google Gemini Pro Vision、Zhipu GLM-4 Vision等具有視覺辨識能力的大型語言模型,使LobeChat具備多模態互動能力。

用戶可以輕鬆地將圖片上傳或拖放到聊天框中,助理將能夠辨識圖片內容並進行智慧對話。

✅ 文字到圖像生成。

您可以在與助手對話時直接使用文字轉圖像工具。

透過使用 DALL-E 3、MidJourney 和 Pollinations 等人工智慧工具的強大功能,助手現在可以正確實施它。

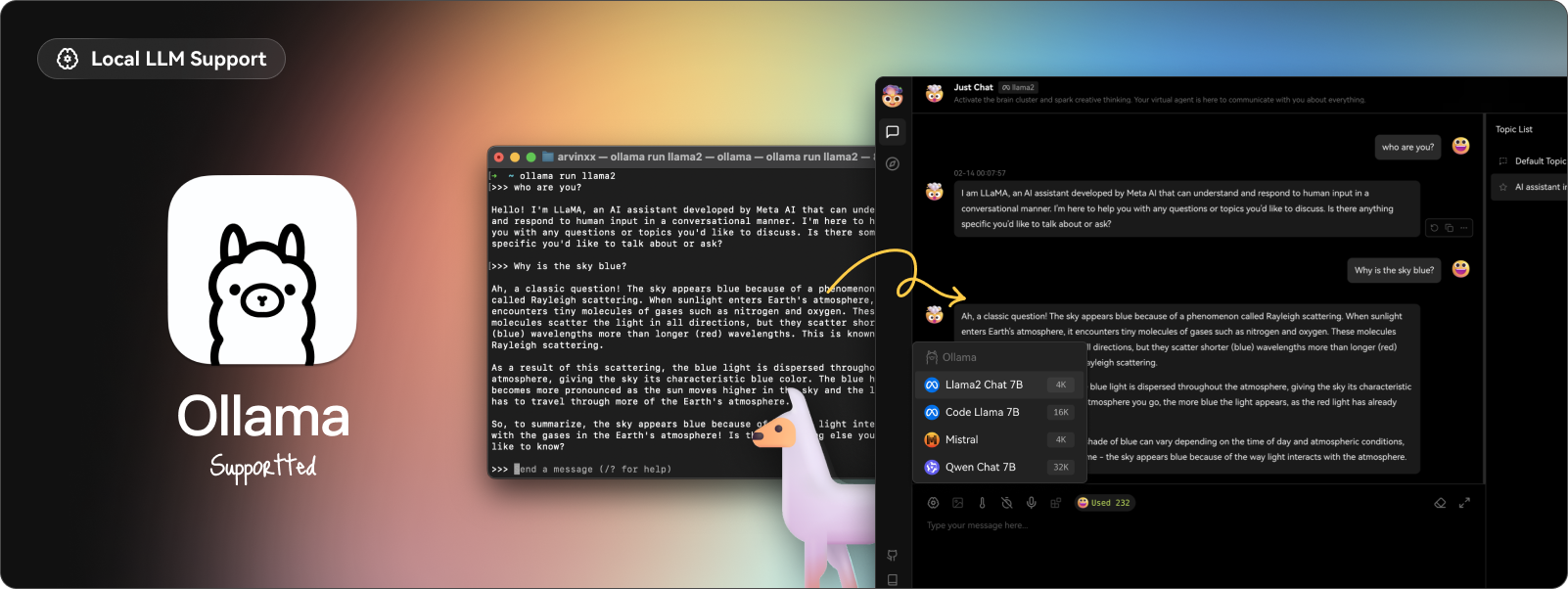

✅ 本地大語言模型 (LLM) 支援。

借助 Ollama AI 強大的基礎設施和社區的協作努力,現在您可以在 LobeChat 中與本地 LLM(大型語言模型)進行對話!

透過執行以下 Docker 指令,您可以在 LobeChat 中體驗與本機 LLM 的對話。

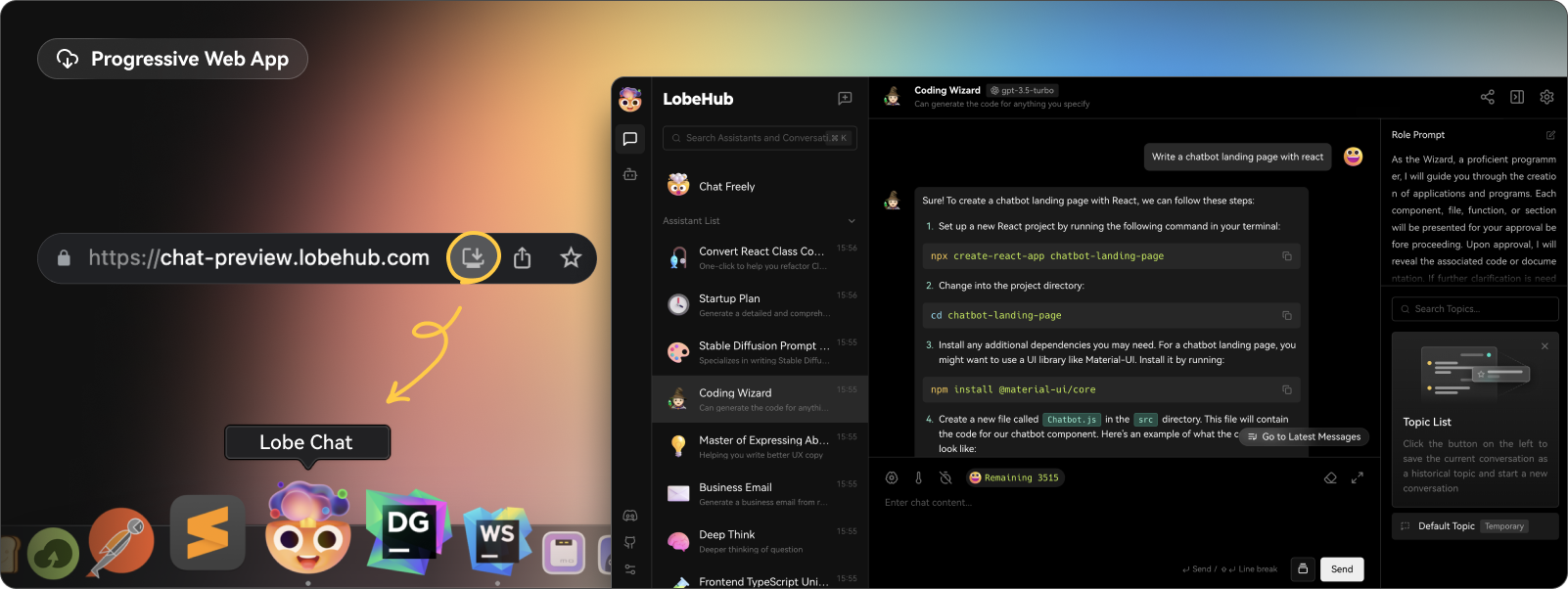

docker run -d -p 3210:3210 -e OLLAMA_PROXY_URL=http://host.docker.internal:11434/v1 lobehub/lobe-chat✅ 漸進式網頁應用程式 (PWA)。

他們採用了漸進式 Web 應用程式 PWA 技術,這是一種現代 Web 技術,可將 Web 應用程式提升到接近本機應用程式的體驗。

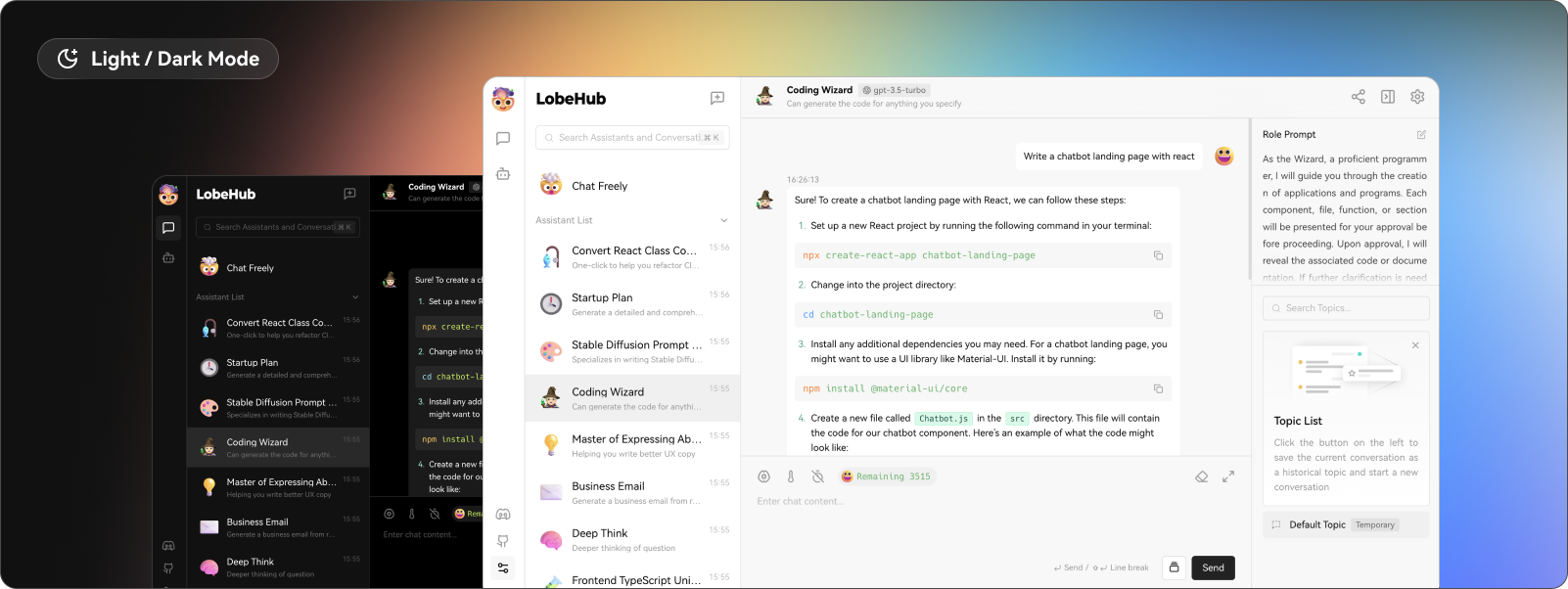

✅ 自訂主題。

了解所有功能和用例。

您可以自行託管或使用 docker 部署它。 lobe chat 的生態系統提供了 4 個軟體包: lobehub/ui 、 lobehub/icons 、 lobehub/tts和lobehub/lint 。

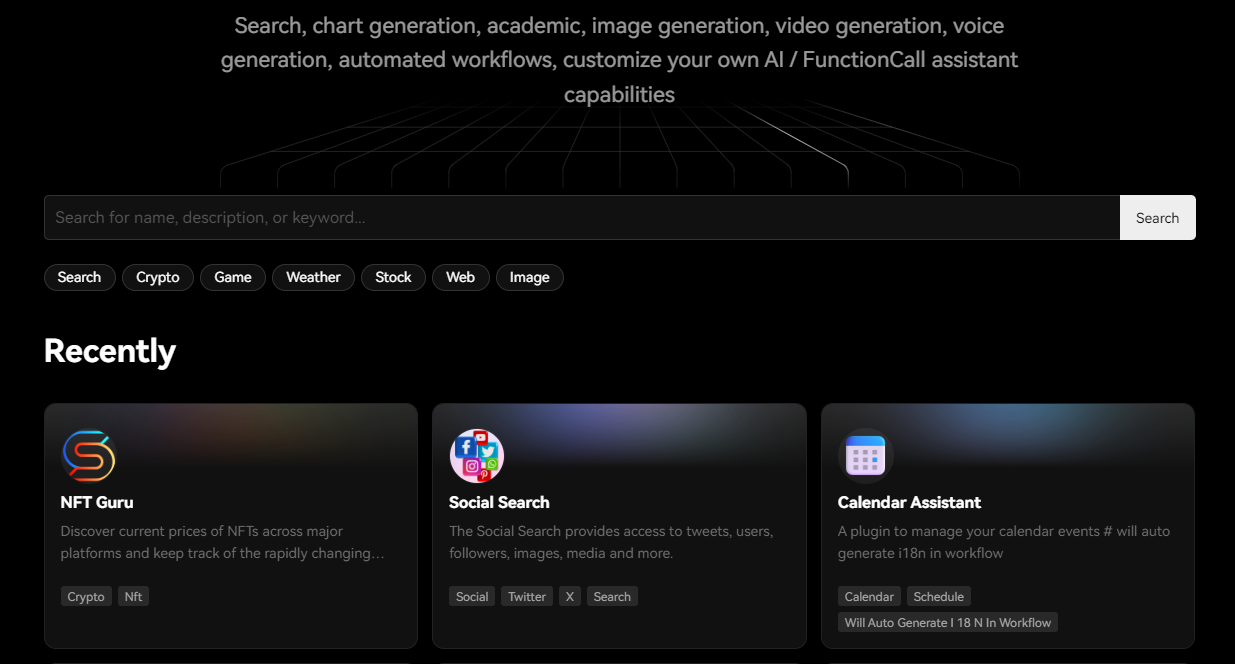

他們還提供插件市場,您可以在其中找到許多有用的插件,這些插件可用於引入新的函數呼叫,甚至是呈現訊息結果的新方法。如果你想開發自己的插件,請參考 wiki 中的📘插件開髮指南。

您可以閱讀文件。

您可以查看現場演示。它太酷了!

他們在 GitHub 上擁有超過 35k 顆星,發布了 500 多個版本。

https://github.com/lobehub/lobe-chat 星瓣聊天 ⭐️

-

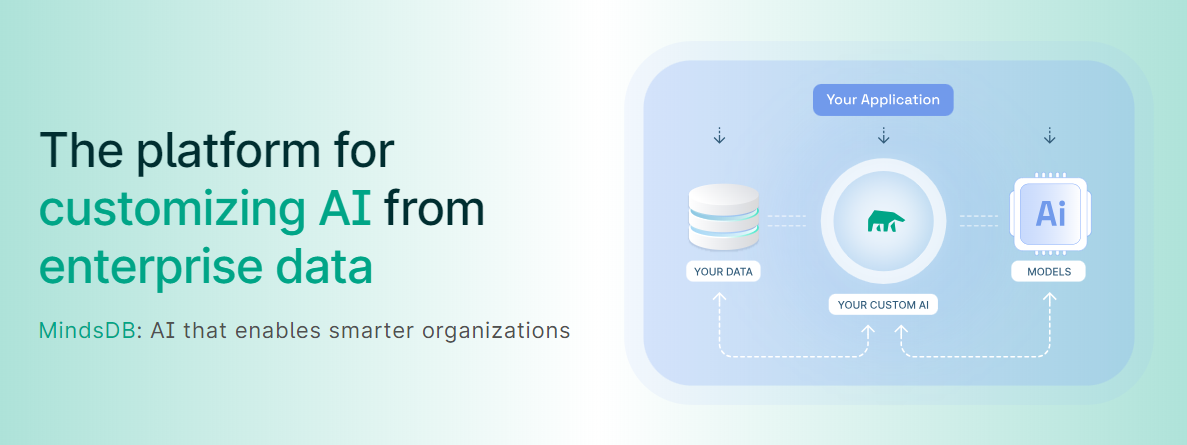

MindsDB - 從企業資料客製化人工智慧的平台。

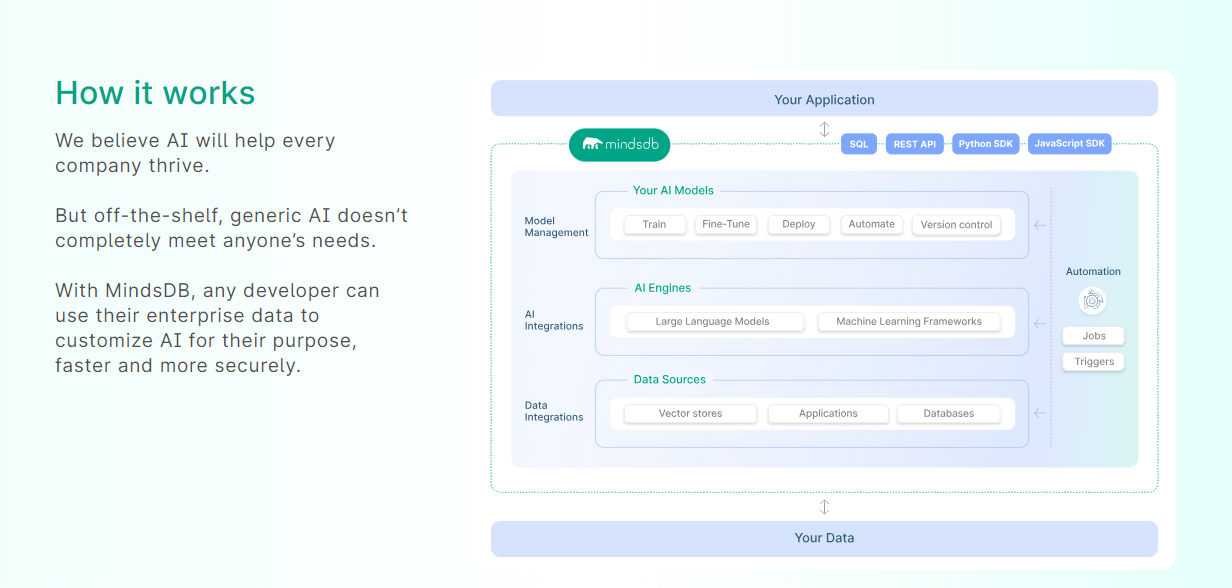

MindsDB 是一個利用企業資料客製化人工智慧的平台。

透過 MindsDB,您可以利用資料庫、向量儲存或應用程式中的資料即時部署、服務和微調模型,以建立人工智慧驅動的應用程式 - 使用開發人員已知的通用工具。

借助 MindsDB 及其與資料來源和 AI/ML 框架的近200 個集成,任何開發人員都可以使用其企業資料更快、更安全地自訂符合其目的的 AI。

目前,他們總共支援3 個使用 Mongo-QL、Python 和 JavaScript 的 SDK 。

MindsDB 有多種應用程式,例如與眾多資料來源和 AI 框架集成,因此您可以輕鬆地將資料和 AI 結合在一起以建立和自動化自訂工作流程。

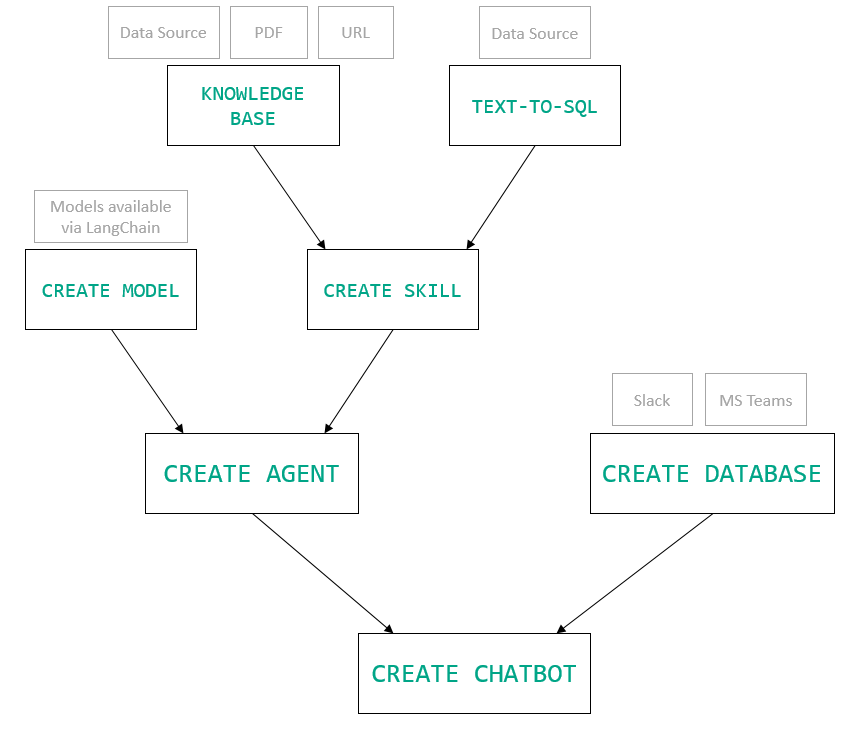

其他常見用例包括微調模型、聊天機器人、警報系統、內容生成、自然語言處理、分類、回歸和預測。閱讀有關用例的更多訊息,每個用例都有一個包含一些資訊的架構圖。

例如,MindsDB 的聊天機器人架構圖。您可以閱讀提供的所有解決方案及其 SQL 查詢範例。

// SQL Query Example for Chatbot

CREATE CHATBOT slack_bot USING database='slack',agent='customer_support';

只是為了告訴您總體的可能性,您可以查看如何使用 AI + IoT 感測器資料預測氣溫。令人興奮的權利:)

他們在 GitHub 上擁有超過 25,400 顆星,並且在v24.7.2.0上有超過 200 個版本。順便說一句,這是我第一次在任何版本中看到 4 個部分,因為我一直遵循語義版本。

https://github.com/mindsdb/mindsdb 明星 MindsDB ⭐️

-

AutoGPT - 比 ChatGPT 更精彩。

AutoGPT 的核心在於其主要專案,即由大型語言模型 (LLM) 驅動的半自治代理,旨在為您執行任何任務。

AutoGPT 計畫由四個主要部分組成:

-

代理 – 也稱為“AutoGPT”

-

基準 – 又稱 agbenchmark

-

熔爐

-

前端

了解如何使用 OpenAI 金鑰設定 AutoGPT 。

您可以觀看Fireship 發布的有關 AutoGPT 的 YouTube 影片。

https://www.youtube.com/watch?v=\_rGXIXyNqpk

您也可以觀看 Sentral Media 提供的AutoGPT 教學。

即使您對 AI 不太了解,您也可以嘗試 AutoGPT 以了解如何節省時間並建立很酷的東西。

由於如此出色的用例和自動化功能,他們在 GitHub 上擁有 164k+ 顆星。

https://github.com/Significant-Gravitas/AutoGPT 明星 AutoGPT ⭐️

-

reor - 自組織人工智慧筆記應用程式。

迄今為止我見過的最令人興奮的專案之一,特別是因為它在本地執行模型。

Reor 是一款由人工智慧驅動的桌面筆記應用程式。它會自動連結相關筆記、回答筆記上的問題並提供語義搜尋。

所有內容都儲存在本地,您可以使用類似黑曜石的 Markdown 編輯器來編輯筆記。該專案假設人工智慧思維工具預設應該在本地執行模型。

Reor 站在Ollama 、 Transformers.js和LanceDB等巨頭的肩膀上,使 LLM 和嵌入模型都可以在本地執行。也支援連接到 OpenAI 或 OpenAI 相容的 API(例如 Oobabooga)。

我知道你想知道它怎麼可能是

self-organizing?

A。您寫的每個筆記都會被分塊並嵌入到內部向量資料庫中。

b.相關筆記透過向量相似度自動連接。

C。 LLM 支援的問答對筆記語料庫進行 RAG。

d.一切都可以進行語義搜尋。

您可以在這裡觀看演示!

將 Reor 視為一個帶有兩個生成器的 RAG 應用程式:LLM 和人類。在問答模式下,LLMs將從語料庫中獲取檢索到的上下文,以幫助回答查詢。

同樣,在編輯器模式下,我們可以切換側邊欄以顯示從語料庫中retrieved相關註釋。這是一種非常強大的方式,可以透過將當前筆記中的想法與數位收藏中的相關想法交叉引用來augmenting您的想法。

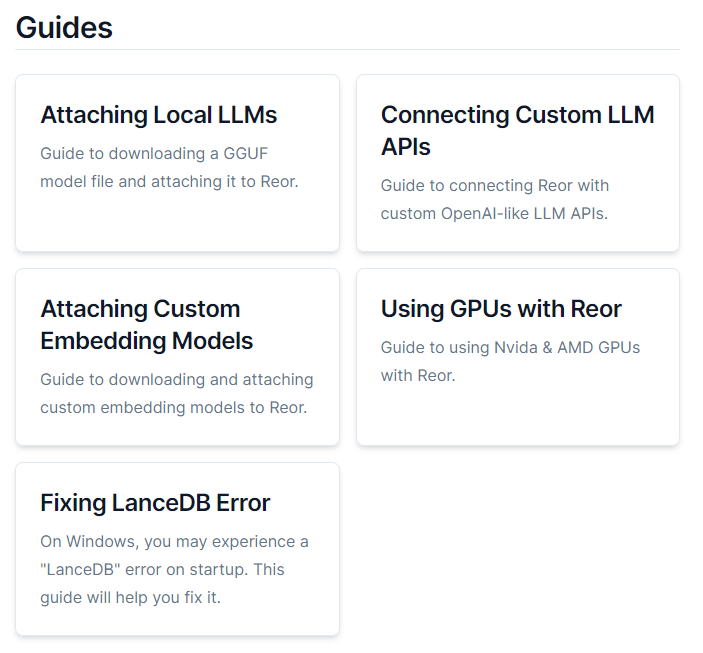

您可以閱讀文件並從網站下載。 Mac、Linux 和 Windows 皆支援。

他們還提供了入門指南來幫助您入門。

您還可以觀看此演練!

https://www.youtube.com/watch?v=2XFYyrQz9xQ&pp=ygUYcmVvciBvcGVuIHNvdXJjZSBwcm9qZWN0

它們在 GitHub 上有 6500 顆星,並使用 TypeScript 建置。

https://github.com/reorproject/reor 星標 reor ⭐️

-

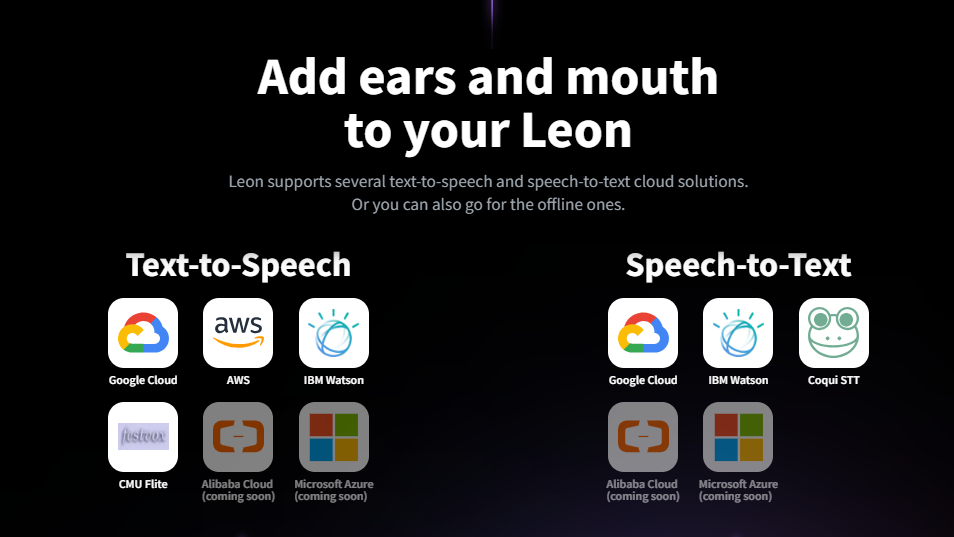

Leon - 您的開源個人助理。

Leon 是一個開源個人助理,可以駐留在您的伺服器上。你一定很好奇,對吧? 😅

當你要求他做事時,他就會做事。你甚至可以和他說話,他會透過和你說話來恢復。同樣,你也可以傳簡訊給他!

如果您是開發人員(或不是),您可能想要建立許多對您的日常生活有幫助的東西。 Leon 可以透過他的Skills結構來幫助您,而不是為每個想法建立專門的專案。

如果您願意,Leon 可以透過離線方式與您溝通,以保護您的隱私。這是萊昂目前可以做的技能清單。

你應該讀一下萊昂背後的故事。您還可以觀看此演示以了解有關 Leon 的更多資訊。

https://www.youtube.com/watch?v=p7GRGiicO1c

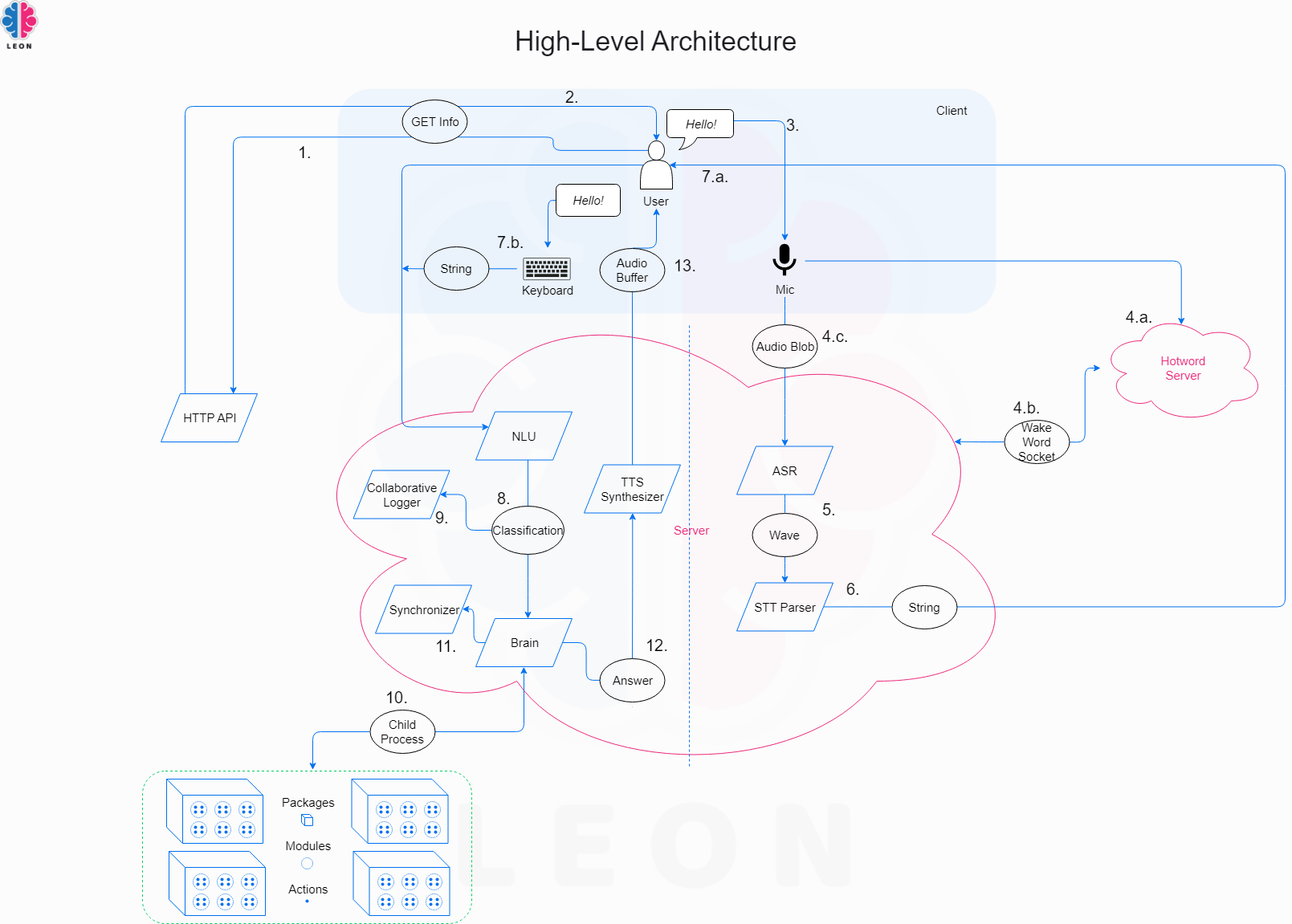

這是Leon的高層架構模式。

您可以使用此命令安裝 Leon。

# install leon global cli

npm install --global @leon-ai/cli

# install leon

leon create birth您可以閱讀文件。

Appwrite 是贊助商之一,充分說明了其整體影響。

它在 GitHub 上有 15k 顆星,並且最近發布了一些重大更改,因此請務必格外小心地閱讀文件。

https://github.com/leon-ai/leon 明星萊昂 ⭐️

-

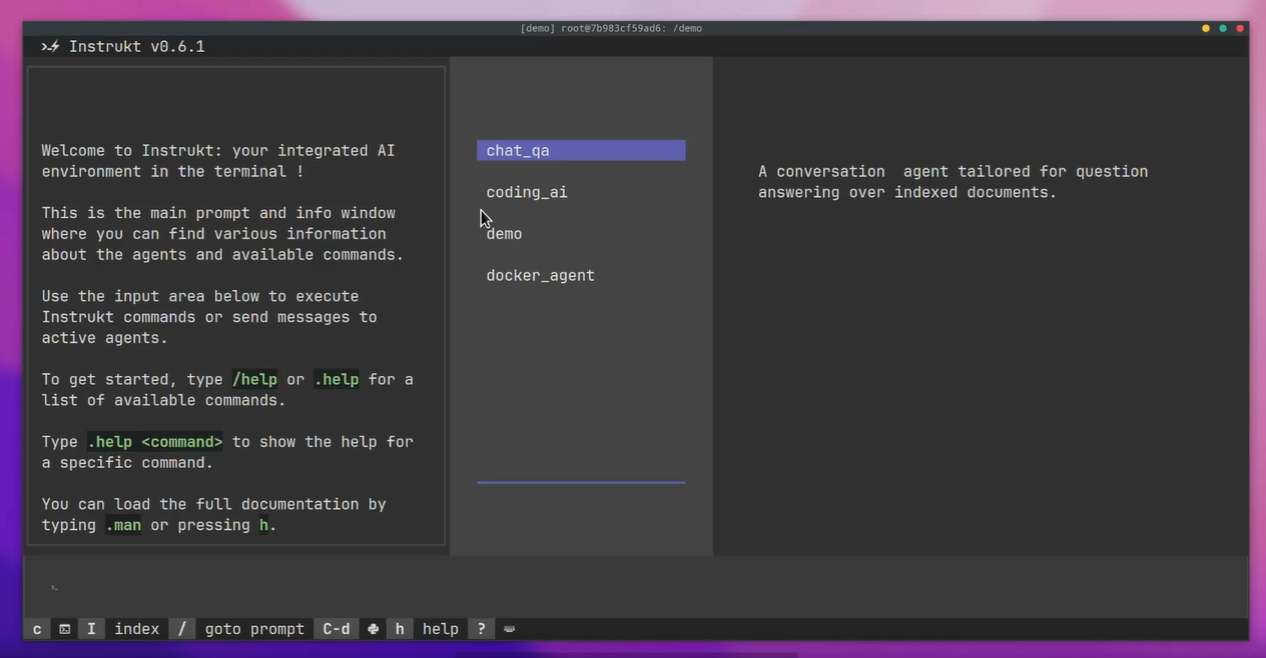

Instrukt - 終端機中整合人工智慧。

Instrukt是一個基於終端的AI整合環境。它提供了一個平台,用戶可以:

-

建立並指導模組化人工智慧代理。

-

產生問答的文件索引。

-

建立工具並將其附加到任何代理程式。

用自然語言指導它們,並且為了安全起見,在安全容器(目前使用 Docker 實現)中執行它們,以在其專用的沙盒空間中執行任務。

它是使用Langchain 、 Textual和Chroma建構的。

開始使用以下命令。

pip install instrukt[all]

有許多令人興奮的功能,例如:

✅ 基於終端的介面,讓強力鍵盤使用者無需離開鍵盤即可指示 AI 代理。

✅ 索引您的資料並讓代理程式檢索它以進行問答。您可以使用簡單的 UI 建立和組織索引。

✅ 索引建立將自動偵測程式語言並相應地最佳化分割/分塊策略。

✅ 在安全的 docker 容器內執行代理程式以確保安全和隱私。

✅ 整合 REPL-Prompt,用於與代理快速交互,以及用於開發和測試的快速回饋循環。

✅ 您可以使用自訂指令自動執行重複任務。它還具有內建的提示/聊天歷史記錄。

您可以閱讀有關所有功能的資訊。

您可以閱讀安裝指南。

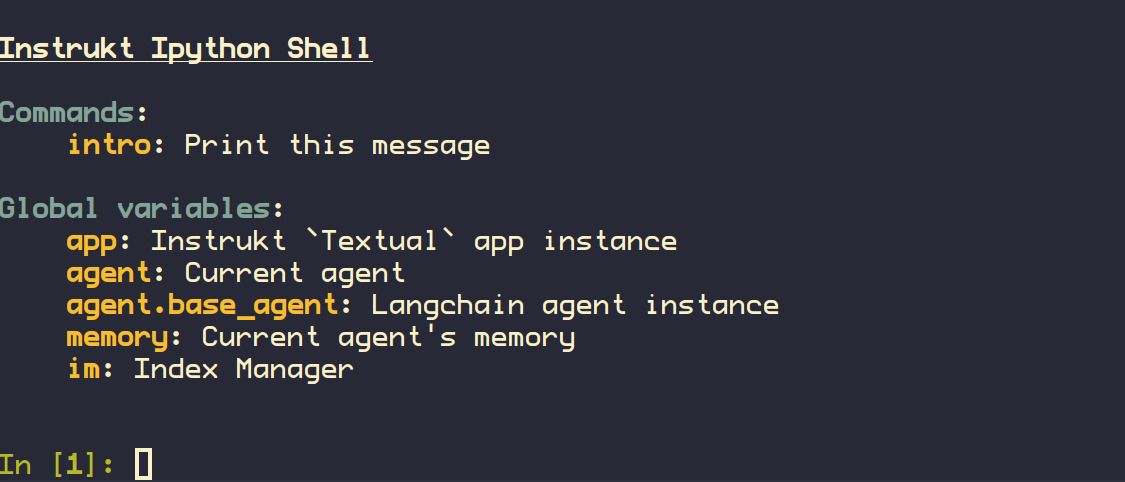

您還可以使用內建的 IPython 控制台來除錯和內省代理,這是一個簡潔的小功能。

Instrukt 已獲得 AGPL 許可證,這意味著任何人都可以將其用於任何目的。

可以肯定地說,Instrukt 是您終端的人工智慧指揮官。

這是一個新專案,因此他們在 GitHub 上有大約 240 顆星,但用例非常好。

https://github.com/blob42/Instrukt Star Instrukt ⭐️

-

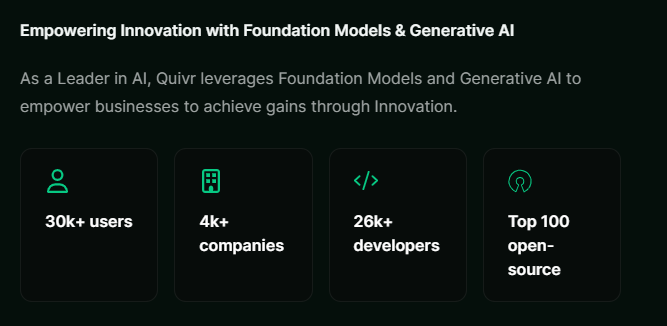

Quivr - 用於建構 GenAI 第二腦的 RAG 框架。

Quivr,您的第二個大腦,利用 GenerativeAI 的力量成為您的私人助理!你可以把它想像成黑曜石,但增強了人工智慧的能力。

Quivr 是一個能夠創造人工智慧助理的平台,稱為Brain 。這些助手具有專門的功能,例如某些助手可以連接到特定的資料來源,允許使用者直接與資料互動。

而其他一些則作為由 Rag 技術提供支援的特定用例的專用工具。這些工具處理特定的輸入以產生實用的輸出,例如摘要、翻譯等。

觀看 Quivr 的快速示範!

一些令人驚奇的功能是:

✅ 您可以根據您希望互動的資料來源選擇您想要使用的 Brain 類型。

✅ 它們還提供了與他人分享您的大腦的強大功能。這可以透過電子郵件與個人共享並為他們分配特定權限來完成。

✅ Quivr 離線工作,因此您可以隨時隨地存取您的資料。

✅ 您可以透過大腦存取並繼續您過去的對話。

✅ 但我最喜歡的一點是,你可以真正安裝 Slack 機器人。請參閱此演示,以了解您可以做什麼。很酷!

不管怎樣,請閱讀有關 Quivr 可以做的所有很棒的事情。

您可以閱讀安裝指南和60秒的安裝影片。我真的很喜歡這個主意!

您可以閱讀文件。

他們還提供了有關如何使用 Vercel、Porter、AWS 和 Digital Ocean 部署 Quivr 的指南。

他們可以提供更好的免費套餐,但這足以在您端進行測試。

它在 GitHub 上擁有超過 30k 顆星,發布了 220 多個版本,這意味著它們正在不斷改進。

https://github.com/QuivrHQ/quivr Star Quivr ⭐️

-

Open Interpreter - 終端的自然語言介面。

Open Interpreter 允許LLMs在本地執行程式碼(Python、Javascript、Shell 等)。您可以在安裝後執行$ interpreter透過終端機中類似 ChatGPT 的介面與 Open Interpreter 聊天。

這為電腦的通用功能提供了自然語言介面:

✅ 建立和編輯照片、影片、PDF 等。

✅ 控制 Chrome 瀏覽器執行研究、繪製、清理和分析大型資料集。

我不了解你,但他們的網站讓我驚嘆不已!

使用此命令快速啟動。

pip install open-interpreter

// After installation, simply run:

interpreter您可以閱讀快速入門指南。

您應該閱讀與 ChatGPT 程式碼解釋器的比較以及可以使用的命令。

您可以閱讀文件。

Open Interpreter 可與託管語言模型和本機語言模型搭配使用。託管模型速度更快、功能更強大,但需要付費,而本地型號是私有且免費的,但功能通常較差。根據您的使用情況進行選擇!

它們在 GitHub 上擁有超過 48k 顆星,並被 300 多名開發人員使用。

https://github.com/OpenInterpreter/open-interpreter Star 開放式解釋器 ⭐️

-

CopilotKit - 建造 AI Copilot 的難度提高了 10 倍。

您會同意在 React 中加入 AI 功能很困難,這就是 Copilot 作為建置自訂 AI Copilot 的框架可以幫助您的地方。

您可以使用 Copilotkit 提供的簡單元件來建立應用程式內 AI 聊天機器人和應用程式內 AI 代理,這比從頭開始建立至少容易 10 倍。

如果已經有一個非常簡單且快速的解決方案,您就不應該重新發明輪子!

它們還提供內建(完全可自訂)Copilot 原生 UX 元件,例如<CopilotKit /> 、 <CopilotPopup /> 、 <CopilotSidebar /> 、 <CopilotTextarea /> 。

開始使用以下 npm 指令。

npm i @copilotkit/react-core @copilotkit/react-ui這就是整合聊天機器人的方法。

CopilotKit必須包裝與 CopilotKit 互動的所有元件。建議您也開始使用CopilotSidebar (您可以稍後切換到不同的 UI 提供者)。

"use client";

import { CopilotKit } from "@copilotkit/react-core";

import { CopilotSidebar } from "@copilotkit/react-ui";

import "@copilotkit/react-ui/styles.css";

export default function RootLayout({children}) {

return (

<CopilotKit url="/path_to_copilotkit_endpoint/see_below">

<CopilotSidebar>

{children}

</CopilotSidebar>

</CopilotKit>

);

}您可以輕鬆整合 Vercel AI SDK、OpenAI API、Langchain 和其他 LLM 供應商。您可以按照本指南將聊天機器人整合到您的應用程式中。

基本想法是非常快速地建立人工智慧聊天機器人,而不需要付出太多的努力,特別是對於基於LLMs的應用程式。

您可以觀看完整的演練!

CopilotKit 最近在 GitHub 上的星星數超過 7k,發布了 300 多個版本。

https://github.com/CopilotKit/CopilotKit Star CopilotKit ⭐️

-

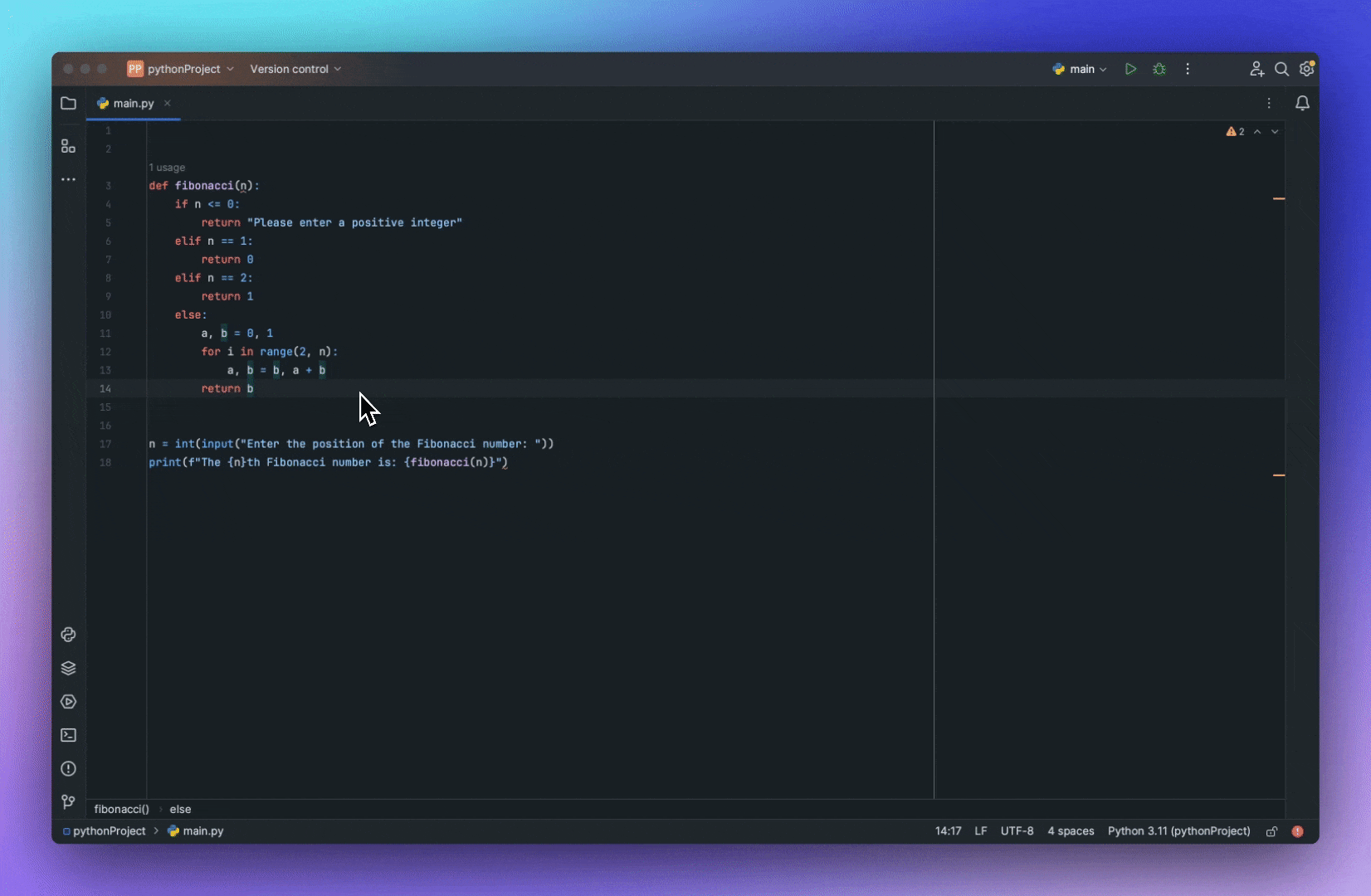

GPT-engineer- AI 建立您所要求的內容。

GPT-engineer 讓您可以用自然語言指定軟體,坐下來觀看 AI 編寫和執行程式碼,您可以要求 AI 實作改進。

可以肯定地說,這是一個不需要學位的工程師😅

這是一個自動產生網路應用程式的商業專案。它為連接到 git 控制的程式碼庫的非技術用戶提供了一個 UI。

我知道這讓人感到困惑,所以請觀看下面的演示以了解如何使用 GPT Engineer。

您可以使用此命令安裝穩定版本來開始。

python -m pip install gpt-engineer預設情況下,gpt-engineer 期望透過提示檔輸入文字。它還可以接受具有視覺功能的模型的圖像輸入。這對於加入 UX 或架構圖作為 GPT 工程師的附加上下文非常有用。了解所有出色的功能。

如果您想要完整的演練,請觀看 David 製作的精彩示範!

https://www.youtube.com/watch?v=gWy-pJ2ofEM

我建議查看路線圖以了解整體願景。

他們在 GitHub 上擁有超過 51k 顆星,並且發布了v0.3版本。

https://github.com/gpt-engineer-org/gpt-engineer GPT 明星工程師 ⭐️

-

Dalai - 在本地執行 LLaMA 和 Alpaca 的最簡單方法。

Dalai 允許您在電腦上執行 LLaMA 和 Alpaca,並由llama.cpp 、 llama-dl CDN和alpaca.cpp提供支援。

Dalai 可以在 Linux、Mac 和 Windows 等作業系統上執行,所以這是一個優點!

Dalai也是NPM包:

-

以程式設計方式安裝

-

在本地向模型發出請求

-

執行 dalai 伺服器(由 socket.io 提供支援)

-

以程式方式向遠端 dalai 伺服器發出請求(透過 socket.io)

您可以使用以下 npm 命令安裝該軟體包。

npm install dalai

您可以閱讀記憶體需求以及 如何在主目錄以外的其他地方存檔。

他們在 GitHub 上擁有 13k star,且仍處於早期階段。

https://github.com/cocktailpeanut/dalai 明星達賴 ⭐️

-

OpenLLM - 在雲端中將 LLM 作為 OpenAI 相容 API 端點執行

OpenLLM 允許開發人員使用單一命令將任何開源 LLM 作為與 OpenAI 相容的 API 端點執行。

⚡ 為快速生產使用而建造。

⚡ 支援llama3、qwen2、gemma等,以及許多量化版本完整清單。

⚡ 相容於 OpenAI 的 API 並包含類似 ChatGPT 的 UI。

⚡ 使用最先進的推理後端加速 LLM 解碼。

⚡ 為企業級雲端部署做好準備(Kubernetes、Docker 和 BentoCloud)。

開始使用以下命令。

pip install openllm # or pip3 install openllm

openllm helloOpenLLM 在 LLM 伺服器的 /chat 端點提供聊天使用者介面 (UI)。您可以造訪http://localhost:3000/chat聊天 UI,並開始與模型進行不同的對話。

OpenLLM透過統一模型服務框架BentoML和企業AI團隊的AI推理平台BentoCloud支援LLM雲端部署。

如果您不知道,BentoCloud 提供了一個針對 LLM 推理進行最佳化的完全託管基礎設施,具有自動擴展、模型編排、可觀察性等功能,可讓您在雲端中執行任何 AI 模型。

部署完成後,您可以在 BentoCloud 控制台上執行模型推理:

您可以閱讀有關支援的模型以及如何啟動 LLM 伺服器的資訊。

瀏覽文件,您還可以使用openllm run並指定模型版本 - openllm run llama3:8b在 CLI 中與模型聊天。

對於像我這樣喜歡探索演練的人,請觀看 Matthew 的示範!

https://www.youtube.com/watch?v=8nZZ2oQhx4E&pp=ygUIb3BlbiBsbG0%3D

他們在 GitHub 上擁有超過 9k 顆星,並發布了 100 多個版本,因此它正在快速成長。

https://github.com/bentoml/OpenLLM 明星 OpenLLM ⭐️

-

Unsloth - Finetune Llama 3、Mistral、Phi 和 Gemma LLM 速度提高 2-5 倍,記憶體減少 80%。

Unsloth 使 Llama-3、Mistral、Phi-3 和 Gemma 等大型語言模型的微調速度提高了 2 倍,使用的記憶體減少了 70%,並且準確性沒有下降!

✅ 什麼是微調?

如果我們希望語言模型學習新技能、新語言、某種新程式語言,或者只是希望語言模型學習如何遵循和回答指令(例如 ChatGPT 的功能),我們會進行微調!

微調是透過稱為反向傳播的過程更新語言模型的實際brains的過程。但是,微調可能會變得非常緩慢並且非常耗費資源。

Unsloth 可以在本機安裝,也可以透過其他 GPU 服務(例如 Google Colab)安裝。大多數人透過 Google Colab 介面使用 Unsloth,該介面提供免費的 GPU來進行訓練。

一些突出的事情:

✅ 開源訓練速度快了 5 倍,專業版聲稱速度快了 30 倍。

✅ 不使用近似方法,導致精度損失 0%。

✅ 無需更改硬件,可透過 WSL 在 Linux 和 Windows 上執行。

您可以直接在 Hugging Face 上閱讀文件和所有上傳的模型。

他們還提供了有關如何微調 Llama-3 和導出到 Ollama 的詳細指南。

他們在 GitHub 上擁有超過 12,500 顆星,這是一個有效的解決方案。

https://github.com/unslothai/unsloth 明星 Unsloth ⭐️

我希望你學到新東西了!

我相信學習使用這些強大的LLMs是一種選擇,您(作為開發人員)可以為您的用例找到更好的生產力解決方案。

祝你有美好的一天!

原文出處:https://dev.to/latitude/21-open-source-llm-projects-to-become-10x-ai-developer-fe0

1) --- 會變成分隔線(上一行必須是空白)

2) # 會變成一級標題

3) ## 會變成二級標題

4) ### 會變成三級標題

5) **粗體文字**會顯示粗體文字

6) ```當第一行與最後一行會顯示程式碼

7) 請搜尋 Markdown 語法,了解各種格式